Потеря валидации отскакивает случайным образом при обучении модели Keras независимо от используемого оптимизатора

Я переучиваю модель InceptionV3 на 200 изображениях и использую оптимизатор Adam:

opt = Adam(lr=0.0001, decay=0.0001 / 100)

Я заметил, что убыток отскакивает специально от валидации. Я подумал, что это связано со скоростью обучения, как я видел в некоторых ответах, таких как странное поведение Transfer Learning - Val_loss, а также Почему в сверточной нейронной сети могут быть низкие потери, но также очень низкая точность? они не помогли.

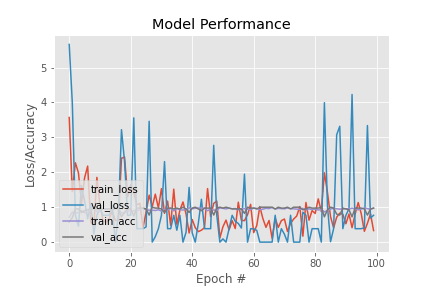

поэтому я использовал RMSprop, но у меня было такое же поведение. Вот как выглядит перформанс:

Есть предложения, почему я испытываю это и как с этим справиться?

1 ответ

Глядя на ваши графики, я не думаю, что сеть действительно чему-то учится.

Предлагаю вам изучить следующее:

Есть ли в изображениях какой-либо ввод с нулем.

Градиенты слишком большие или слишком маленькие.

Почти постоянные градиенты для нескольких партий.

Одинаковы ли масштабы всех изображений.

Правильно ли закодированы классы как горячие векторы.