Проекция трехмерной лидарной точки на изображение i-й камеры (набор данных KITTI)

Я работаю над проблемой классификации объектов и использую данные лидара и камеры из набора данных Kitti. В этой статье: http://ww.cvlibs.net/publications/Geiger2013IJRR.pdf, они предоставляют формулы для проецирования трехмерного изображения. PointCloud в плоскость изображения i-й камеры, но я не понимаю некоторые вещи:

Следующее уравнение ((3):

Если 3D-точка X находится на изображении с камеры и Y на изображении с i-й камеры, почему X имеет четыре координаты, а Y три? Должно было быть 3 и 2, нет?

Мне нужно спроецировать трехмерное облако точек на плоскость изображения камеры, чтобы затем создать лидарные изображения, чтобы использовать их в качестве канала для CNN. У кого есть идеи для этого?

Заранее спасибо

1 ответ

Для вашего первого запроса относительно размера x и y есть два объяснения.

Причина 1

Для повторного проецирования изображения используется модель камеры с отверстием в виде булавки, которая находится в перспективе или однородной координате. Перспективная проекция использует источник изображения в качестве центра проекции, а точки отображаются на плоскость z=1. Трехмерная точка [x y z] представлена как [xw yw zw w], а точка, которую она отображает на плоскости, представлена как [xw yw zw]. Нормализация с помощью w дает.

Итак (x, y) -> [xy 1] T: однородные координаты изображения

и (x, y, z) -> [xyz 1] T: однородные координаты сцены

Причина 2

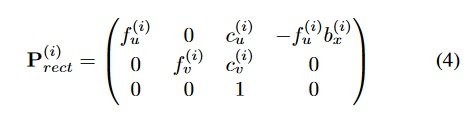

Что касается бумаги, которую вы приложили, учитывая уравнения (4) и (5)

Ясно, что P имеет размерность 3X4 и R расширяется до размера 4x4. Также x имеет размерность 1x4. Таким образом, согласно правилу умножения матриц количество столбцов первой матрицы должно равняться количеству строк второй матрицы. Таким образом, для данного P 3x4 и R 4x4, x должен быть 1x4.

Теперь перейдем ко второму вопросу о слиянии изображений LiDAR. Для него требуются внутренние и внешние параметры (относительное вращение и перемещение) и матрица камеры. Это вращение и перемещение образуют матрицу 3x4, называемую матрицей преобразования. Таким образом, точечные уравнения слияния становятся

[x y 1]^T = Transformation Matrix * Camera Matrix * [X Y Z 1]^T

Вы также можете сослаться:: Lidar Image Fusion KITTI

Как только слияние изображений LiDAR будет завершено, вы можете ввести это изображение в модель CNN. Я не знаю модулей DNN для слитного изображения LiDAR.

Надеюсь это поможет..