Время ожидания второго ParallelRunStep в конвейере истекает при запуске

Я пытаюсь запустить последовательность из более чем одного ParallelRunStepв конвейере AzureML. Для этого я создаю шаг со следующим помощником:

def create_step(name, script, inp, inp_ds):

out = pip_core.PipelineData(name=f"{name}_out", datastore=dstore, is_directory=True)

out_ds = out.as_dataset()

out_ds_named = out_ds.as_named_input(f"{name}_out")

config = cont_steps.ParallelRunConfig(

source_directory="src",

entry_script=script,

mini_batch_size="1",

error_threshold=0,

output_action="summary_only",

compute_target=compute_target,

environment=component_env,

node_count=2,

logging_level="DEBUG"

)

step = cont_steps.ParallelRunStep(

name=name,

parallel_run_config=config,

inputs=[inp_ds],

output=out,

arguments=[],

allow_reuse=False,

)

return step, out, out_ds_named

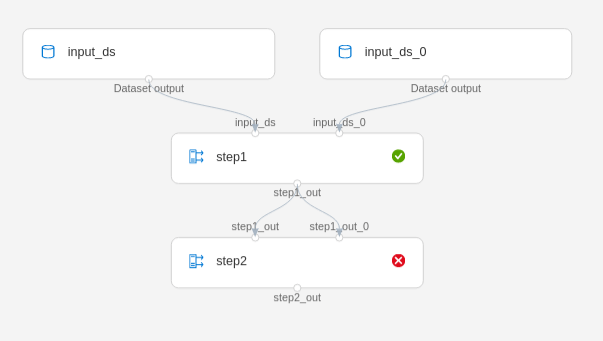

В качестве примера я создаю два таких шага

step1, out1, out1_ds_named = create_step("step1", "demo_s1.py", input_ds, named_input_ds)

step2, out2, out2_ds_named = create_step("step2", "demo_s2.py", out1, out1_ds_named)

Создание эксперимента и его отправка в существующую рабочую область, и вычислительный кластер Azure ML работает. Также первый шагstep1 использует input_ds запускает свой сценарий demo_s1.py (который создает свои выходные файлы и успешно завершается.

Однако второй шаг step2 никогда не начинай.

И последнее исключение

The experiment failed. Finalizing run...

Cleaning up all outstanding Run operations, waiting 300.0 seconds

2 items cleaning up...

Cleanup took 0.16968441009521484 seconds

Starting the daemon thread to refresh tokens in background for process with pid = 394

Traceback (most recent call last):

File "driver/amlbi_main.py", line 52, in <module>

main()

File "driver/amlbi_main.py", line 44, in main

JobStarter().start_job()

File "/mnt/batch/tasks/shared/LS_root/jobs/pipeline/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/mounts/workspaceblobstore/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/driver/job_starter.py", line 48, in start_job

job.start()

File "/mnt/batch/tasks/shared/LS_root/jobs/pipeline/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/mounts/workspaceblobstore/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/driver/job.py", line 70, in start

master.start()

File "/mnt/batch/tasks/shared/LS_root/jobs/pipeline/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/mounts/workspaceblobstore/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/driver/master.py", line 174, in start

self._start()

File "/mnt/batch/tasks/shared/LS_root/jobs/pipeline/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/mounts/workspaceblobstore/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/driver/master.py", line 149, in _start

self.wait_for_input_init()

File "/mnt/batch/tasks/shared/LS_root/jobs/pipeline/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/mounts/workspaceblobstore/azureml/08a1e1e1-7c3f-4c5a-84ad-ca99b8a6cb31/driver/master.py", line 124, in wait_for_input_init

raise exc

exception.FirstTaskCreationTimeout: Unable to create any task within 600 seconds.

Load the datasource and read the first row locally to see how long it will take.

Set the advanced argument '--first_task_creation_timeout' to a larger value in arguments in ParallelRunStep.

У меня такое впечатление, что второй шаг - это ожидание каких-то данных. Однако первый шаг создает предоставленный выходной каталог, а также файл.

import argparse

import os

def init():

pass

def run(parallel_input):

print(f"*** Running {os.path.basename(__file__)} with input {parallel_input}")

parser = argparse.ArgumentParser(description="Data Preparation")

parser.add_argument('--output', type=str, required=True)

args, unknown_args = parser.parse_known_args()

out_path = os.path.join(args.output, "1.data")

os.makedirs(args.output, exist_ok=True)

open(out_path, "a").close()

return [out_path]

Понятия не имею, как дальше отлаживать. Есть у кого-нибудь идея?

2 ответа

Как следует из ошибки, вам следует установить для параметра --first_task_creation_timeout большее значение.

Вы можете сделать это:

argument = ["--first_task_creation_timeout", 86400]

step = ParallelRunStep(arguments = argument, ...)

Вы можете проверить этот блокнот на параллельную работу и убедиться, что вы используете те же пакеты.https://github.com/Azure/MachineLearningNotebooks/blob/master/how-to-use-azureml/machine-learning-pipelines/parallel-run/tabular-dataset-inference-iris.ipynb