Проблемы с Lua и Torch с GPu

Я пытаюсь запустить программу на основе Lua из OpenNMT. Я следовал процедуре здесь: http://forum.opennmt.net/t/text-summarization-on-gigaword-and-rouge-scoring/85

Я использовал команду:

th train.lua -data textsum-train.t7 -save_model textsum1 -gpuid 0 1 2 3 4 5 6 7

Я использую 8 графических процессоров, но все же процесс чертовски медленный, как будто процесс работает на процессоре. пожалуйста, дайте мне знать, что может быть решением для оптимизации использования графического процессора.

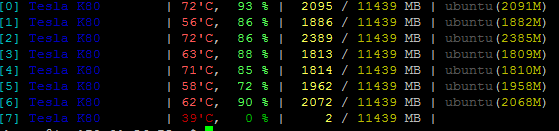

Вот статистика использования GP:

Пожалуйста, дайте мне знать, как я могу ускорить процесс, используя полные графические процессоры. Я доступен с 11 ГБ, но процесс потребляет только 2 ГБ или меньше. Следовательно, процесс чертовски медленный.

1 ответ

Согласно документации OpenNMT, вам необходимо удалить 0 сразу после gpuid вариант с 0 означает процессор, и вы эффективно снижаете скорость обучения до скорости с процессором.

Чтобы использовать параллелизм данных, назначьте список идентификаторов графического процессора для

-gpuidвариант. Например:

th train.lua -data data/demo-train.t7 -save_model demo -gpuid 1 2 4будет использовать первый, второй и четвертый графические процессоры машины в соответствии с API CUDA.