Слишком большие колебания кривой F1 Score во время мета-тренировки с MAML

Я тренируюсь на пользовательском наборе данных изображений для трехсторонней классификации изображений с 5 кадрами, используя fromlearn2learn. Я инкапсулирую весьVGG11модель сMAML, т.е. не только заголовок классификации. Мои гиперпараметры следующие:

- Мета LR: 0,001

- Быстрый LR: 0,5

- Шаги адаптации: 1

- Первый порядок: Ложь

- Размер мета-пакета: 5

- Оптимизатор: AdamW

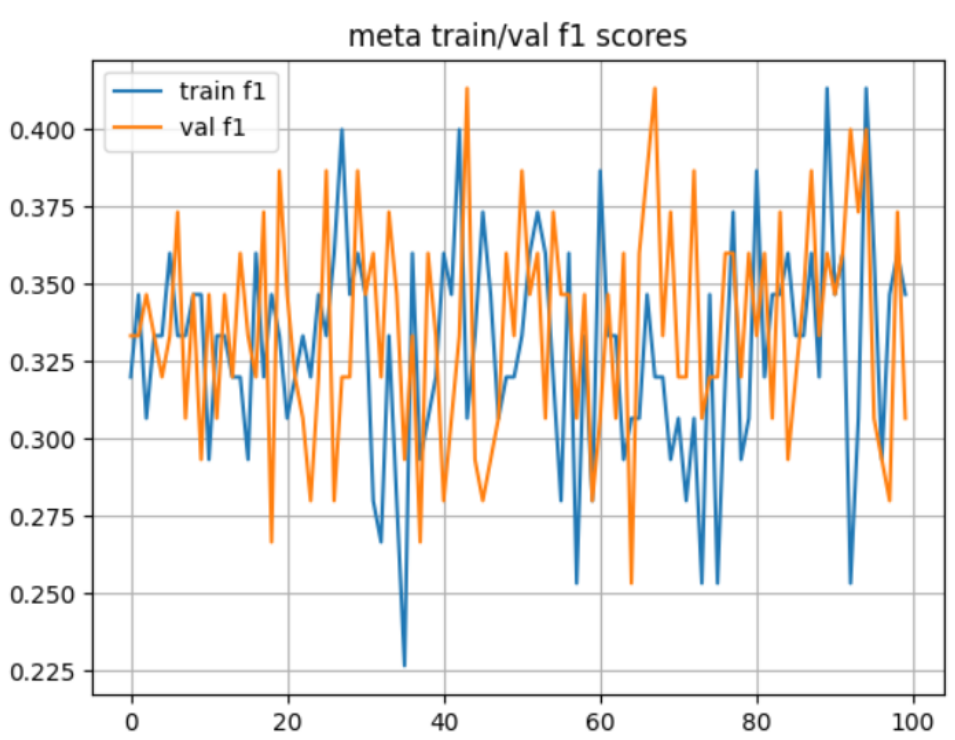

Во время обучения я заметил, что после первого шага оптимизации внешнего цикла, т.е.AdamW.step(), потери взлетают до очень больших значений, например, до десяти тысяч. Это нормально? Кроме того, я измеряю оценку микро-F1 как показатель точности, кривая которого для мета-обучения/проверки выглядит следующим образом:

На мой взгляд, он слишком сильно колеблется, это нормально? Что может быть причиной этого? Спасибо

1 ответ

Я понял. я использовалVGG11с ванильными слоями из PyTorch, которые не работали должным образом в настройке метаобучения. Я удалилBatchNormслои, и теперь он работает как положено.