проверка предтренировочных потерь в huggingface/transformers

Заранее спасибо. Я обучил роберту модели с нуля. Но я не могу проверить потерю тренировки во время предварительной тренировки. Я сделал это, сославшись на ссылку ниже. https://colab.research.google.com/github/huggingface/blog/blob/master/notebooks/01_how_to_train.ipynb в приведенной выше ссылке, потеря печатается каждые 500 шагов (потеря тренировки должна печататься каждые 500 итераций, но есть не входит в предварительную тренировку. (по умолчанию установите logsteps на 500), но когда я это сделал, потери не было.

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20703/20711 [4:42:54<00:07, 1,14 бит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20704/20711 [4:42:54<00:05, 1,24 бит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20705/20711 [4:42:55<00:05, 1,20ит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20706/20711 [4:42:56<00:04, 1,18 бит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20707/20711 [4:42:57<00:03, 1,19ит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20708/20711 [4:42:58<00:02, 1,16ит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20709/20711 [4:42:59<00:01, 1,14 бит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ– ‰ | 20710/20711 [4:43:00<00:00, 1,13ит / с][A

Итерация: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆ | 20711/20711 [4:43:00<00:00, 1,45ит / с] [Итерация: 100%| 20711/20711 [4:43:00 <00:00, 1,22ит / с]

Эпоха: 100%| â – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆâ – ˆ | 13/13 [61:14:16<00:00, 16952.06s/it]

Эпоха: 100%| 13/13 [61:14:16<00:00, 16958.16s/it] сжать roberta.20200717.zip на./pretrained сохранить roberta.20200717.zip на minio(петчарты)

во всей предварительной тренировке не печатается никаких потерь, поэтому я не знаю, хорошо ли прошла тренировка.

пожалуйста помогите. Спасибо.

0 ответов

Просто попробуйте снова запустить записную книжку (например, прямо в colab), используя более новую версию библиотеки, для которой было переработано ведение журнала. Помните, что

Trainer может потребоваться несколько иной набор аргументов из-за устаревания.

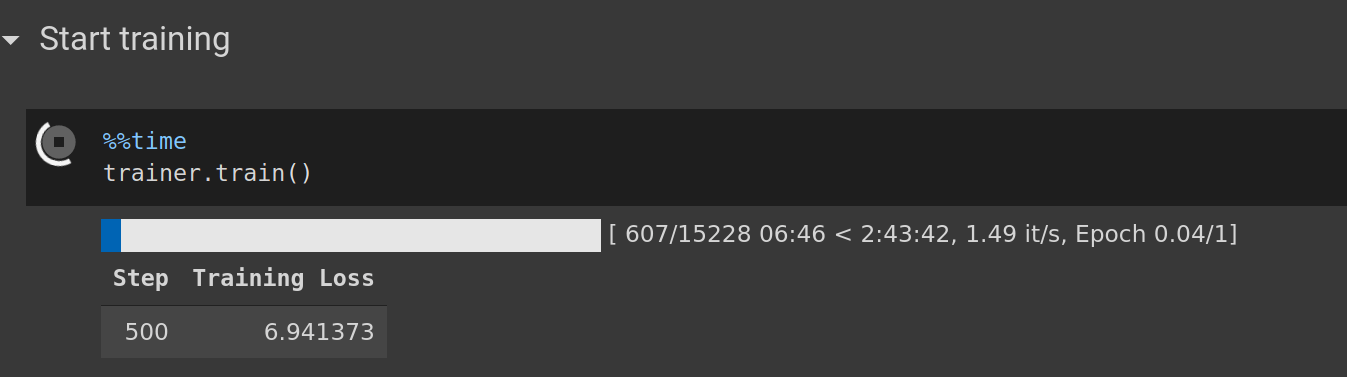

Пример показывает потерю результатов обучения без проблем

я использую

tokenizers 0.9.4

transformers 4.0.0rc1

и эти обучающие аргументы, кажется, делают свою работу:

from transformers import Trainer, TrainingArguments

training_args = TrainingArguments(

output_dir="./EsperBERTo",

overwrite_output_dir=True,

num_train_epochs=1,

per_device_train_batch_size=64,

save_steps=10_000,

save_total_limit=2,

)

trainer = Trainer(

model=model,

args=training_args,

data_collator=data_collator,

train_dataset=dataset,

)