Реализуйте внимание в архитектуре ванильного кодера-декодера

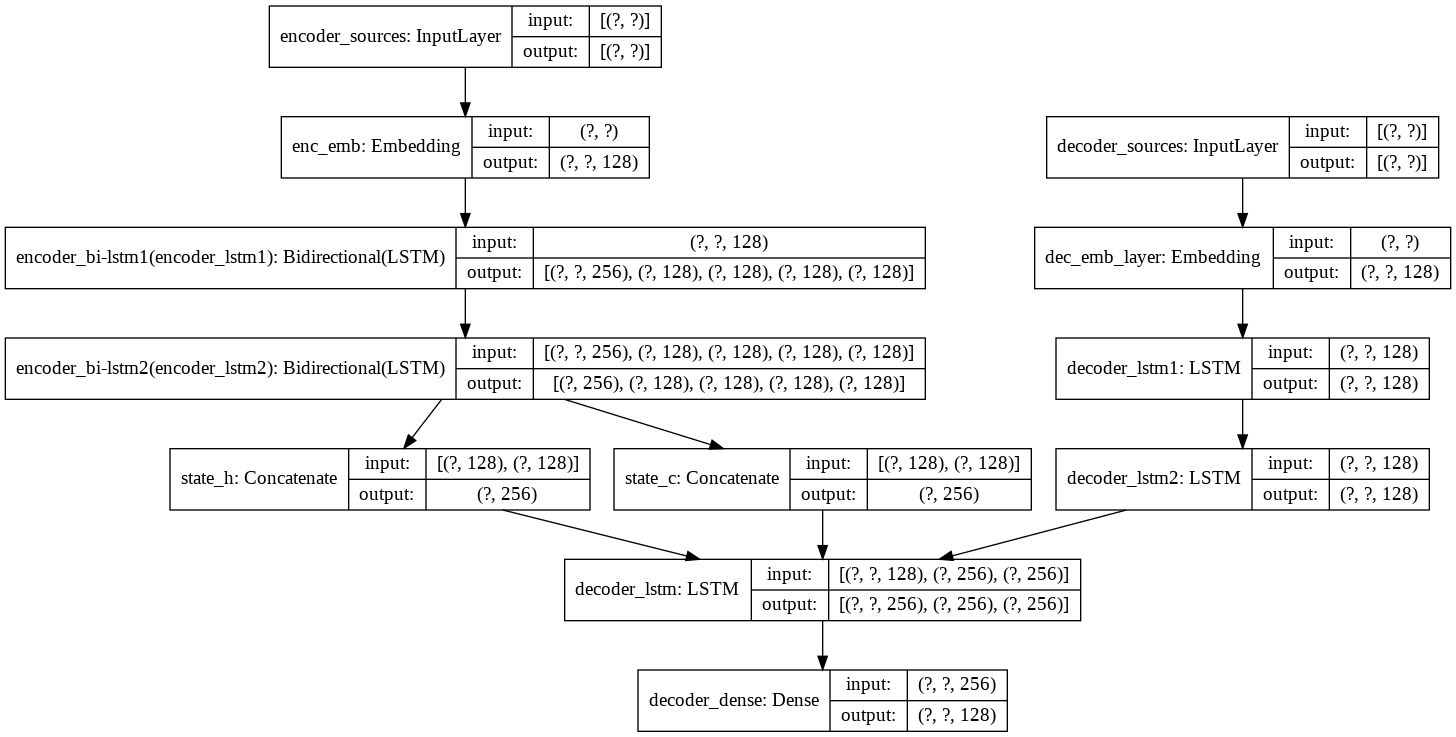

Я пробовал арку vanila enc-dec следующим образом (с английского на французский NMT)

Я хочу знать, как интегрировать здесь слой внимания keras. Также приветствуется либо из документации keras, либо из любого другого модуля внимания из стороннего репо. Мне просто нужно интегрировать его, посмотреть, как он работает, и настроить его.

Полный код доступен здесь.

В этом посте не показан код, потому что он большой и сложный.

1 ответ

Решение

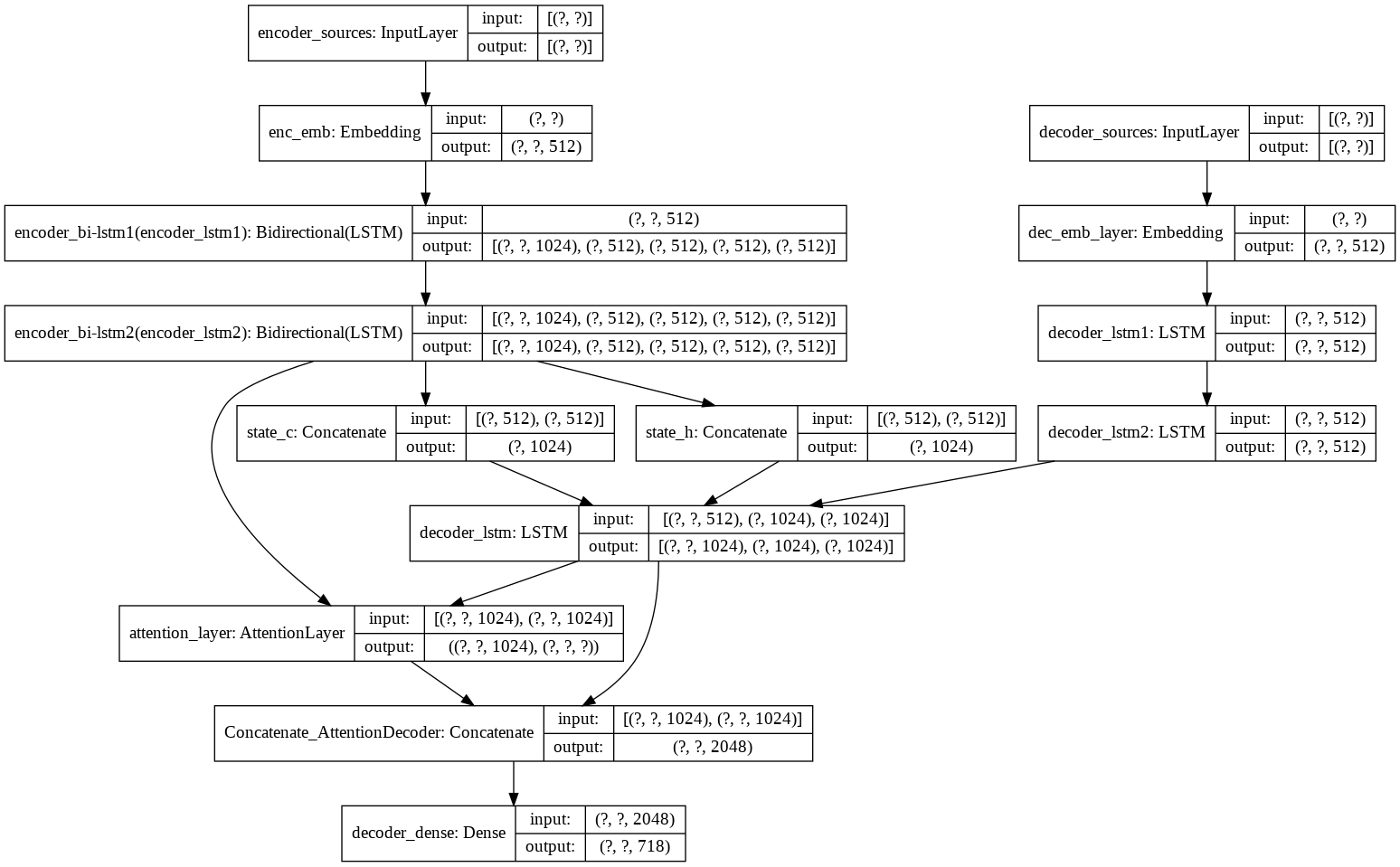

Наконец я решил проблему. Я использую третья сторона, внимание слой на Thushan Ganegedara. Использовал его класс Attentionlayer. И интегрировал это в свою архитектуру следующим образом.