Ray RLlib: Почему при обучении DQN снижается скорость обучения?

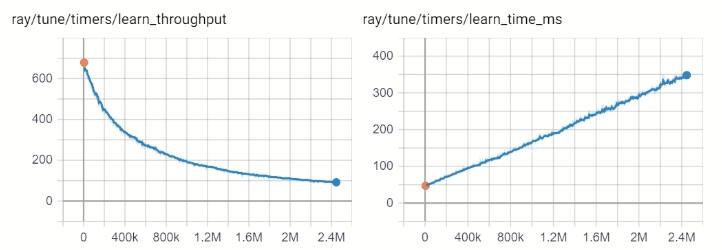

Нормальным ли является уменьшение пропускной способности и увеличение времени обучения при обучении агента Dueling DDQN?

7-кратное увеличение времени обучения после нескольких часов обучения является довольно значительным, ожидаете ли вы этого? Моя система использует только 20% 8-ядерного процессора и 25 ГБ из 64 ГБ памяти.

Модель ray.rllib.agents.dqn в настоящее время обучается на ЦП. Все настройки по умолчанию, кроме

config['timesteps_per_iteration'] = 5000

config['noisy'] = True

config['compress_observations'] = True

config["num_workers"] = 4

config["num_envs_per_worker"] = 8

config["eager"] = True

После дальнейшего обучения пропускная способность упала еще больше до 20. Использование ЦП остается на уровне 20%, использование памяти - 50 ГБ.

Использование Ray 0.8.5, TensorFlow 2.2.0, Python 3.8.3, Ubuntu 18.04 внутри WSL2