Почему весовые параметры логистической регрессии инициализируются нулями?

Я видел веса нейронных сетей, инициализированных случайными числами, поэтому мне любопытно, почему веса логистической регрессии инициализируются нулями?

5 ответов

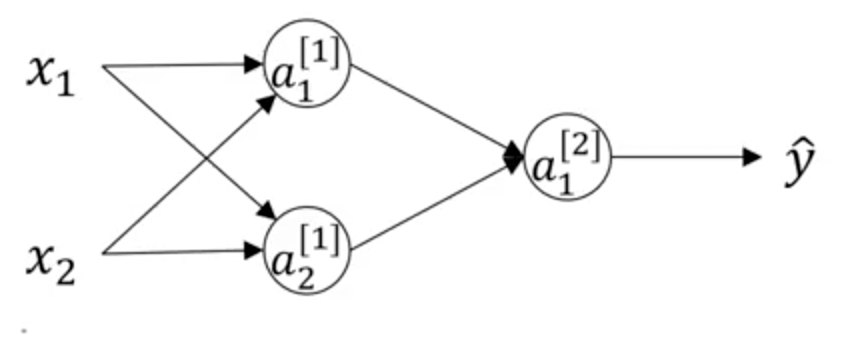

В случае нейронных сетей есть n нейронов в каждом слое. Таким образом, если вы инициализируете вес каждого нейрона с 0, то после обратного распространения каждый из них будет иметь одинаковые веса:

Нейроны a1 и a2 в первом слое будут иметь одинаковые веса независимо от того, как долго вы будете повторять. Так как они рассчитывают одну и ту же функцию.

Что не относится к логистической регрессии, это просто y = Wx + b.

Я думаю, что приведенные выше ответы немного вводят в заблуждение. На самом деле, сигмоидная функция, которая также называется функцией логита, всегда используется в логистической регрессии для своих специальных свойств. Например,

(Извините за некрасивую формулу). И его соответствующая функция показана ниже:  Таким образом, нули гарантируют, что значения всегда находятся в линейной области, что облегчает распространение.

Таким образом, нули гарантируют, что значения всегда находятся в линейной области, что облегчает распространение.

Если все веса инициализированы равными нулю, обратное распространение не будет работать должным образом, потому что градиент для промежуточных нейронов и начальных нейронов исчезнет (станет нулевым) и никогда не будет обновляться. Причина в том, что при обратном проходе NN градиент в некотором промежуточном нейроне умножается на веса исходящего края от этого нейрона к нейрону в следующем слое, который будет равен нулю, и, следовательно, градиент в этом промежуточном узле будет ноль тоже. Впоследствии все веса никогда не улучшатся, и в конечном итоге модель будет корректировать только веса, напрямую связанные только с выходными нейронами.

В логистической регрессии линейное уравнение a = Wx + b, где a — скаляр, а W и x — оба вектора. Производная бинарной взаимной энтропийной потери по одному измерению в весовом векторе W[i] является функцией x[i], которая в целом отличается от x[j], когда i не равно j.

Означает ли это, что нейронная сеть с весами, инициализированными в ноль, так же хороша, как простая логистическая регрессия, или, скажем, NN с одной единицей, которая вычисляет WX+b?