Отображение изображения на трехмерную сетку лица

Я использую iPhone X и ARFaceKit захватить лицо пользователя. Цель состоит в том, чтобы текстурировать сетку лица с изображением пользователя.

Я смотрю только на один кадр (ARFrame) от AR сессия. От ARFaceGeometryУ меня есть набор вершин, которые описывают лицо. Я делаю представление в формате JPEG текущего кадра capturedImage,

Затем я хочу найти координаты текстуры, которые отображают созданный jpeg на вершины сетки. Я хочу: 1. отобразить вершины из модельного пространства в мировое пространство; 2. сопоставить вершины из мирового пространства с пространством камеры; 3. разделить на размеры изображения, чтобы получить пиксельные координаты текстуры.

let geometry: ARFaceGeometry = contentUpdater.faceGeometry!

let theCamera = session.currentFrame?.camera

let theFaceAnchor:SCNNode = contentUpdater.faceNode

let anchorTransform = float4x4((theFaceAnchor?.transform)!)

for index in 0..<totalVertices {

let vertex = geometry.vertices[index]

// Step 1: Model space to world space, using the anchor's transform

let vertex4 = float4(vertex.x, vertex.y, vertex.z, 1.0)

let worldSpace = anchorTransform * vertex4

// Step 2: World space to camera space

let world3 = float3(worldSpace.x, worldSpace.y, worldSpace.z)

let projectedPt = theCamera?.projectPoint(world3, orientation: .landscapeRight, viewportSize: (theCamera?.imageResolution)!)

// Step 3: Divide by image width/height to get pixel coordinates

if (projectedPt != nil) {

let vtx = projectedPt!.x / (theCamera?.imageResolution.width)!

let vty = projectedPt!.y / (theCamera?.imageResolution.height)!

textureVs += "vt \(vtx) \(vty)\n"

}

}

Это не работает, но вместо этого заставляет меня выглядеть очень странно! Куда я иду не так?

1 ответ

Текстурирование сетки лица с помощью изображения пользователя теперь доступно в образце кода Face-Based, опубликованном Apple (раздел Map Camera video on 3D Face Geometry).

Можно отобразить видео с камеры на 3D Face Geometry, используя следующий модификатор шейдера.

// Transform the vertex to the camera coordinate system.

float4 vertexCamera = scn_node.modelViewTransform * _geometry.position;

// Camera projection and perspective divide to get normalized viewport coordinates (clip space).

float4 vertexClipSpace = scn_frame.projectionTransform * vertexCamera;

vertexClipSpace /= vertexClipSpace.w;

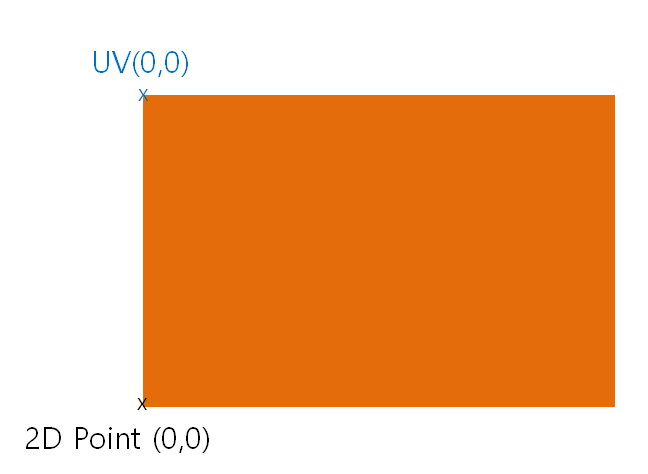

// XY in clip space is [-1,1]x[-1,1], so adjust to UV texture coordinates: [0,1]x[0,1].

// Image coordinates are Y-flipped (upper-left origin).

float4 vertexImageSpace = float4(vertexClipSpace.xy * 0.5 + 0.5, 0.0, 1.0);

vertexImageSpace.y = 1.0 - vertexImageSpace.y;

// Apply ARKit's display transform (device orientation * front-facing camera flip).

float4 transformedVertex = displayTransform * vertexImageSpace;

// Output as texture coordinates for use in later rendering stages.

_geometry.texcoords[0] = transformedVertex.xy;

Для правильного отображения UV вам нужно использовать класс ARSCNFaceGeometry вместо класса ARFaceGeometry, который вы используете в своем коде.

ARSCNFaceGeometry представляет собой представление топологии лица SceneKit для использования с информацией о лице, предоставленной ARSession, Он используется для быстрой визуализации геометрии лица с помощью движка рендеринга SceneKit.

ARSCNFaceGeometry класс является подклассом SCNGeometry который оборачивает данные сетки, предоставленные ARFaceGeometry учебный класс. Ты можешь использовать ARSCNFaceGeometry быстро и легко визуализировать топологию лица и выражения лица, предоставляемые ARKit, в виде SceneKit.

Но ARSCNFaceGeometry доступно только в представлениях SceneKit или средствах визуализации, которые используют Metal. Этот класс не поддерживается для рендеринга SceneKit на основе OpenGL.

Начальная точка отличается:

Примените следующие изменения в вашем коде:

//let vty = projectedPt!.y / (theCamera?.imageResolution.height)!

let vty = ((theCamera?.imageResolution.height)! - projectedPt!.y) / (theCamera?.imageResolution.height)!

Вы можете получить нормальное лицо.