OpenCV, как рассчитать SIFT дескриптор на заданный пиксель

Привет, ребята, я использую opencv3 с Contribu. Вопрос в том, что я хочу вычислить дескриптор просеивания для заданного пикселя (без использования обнаруженных ключевых точек).

Я пытаюсь построить вектор KeyPoint с заданным пикселем. Однако для создания KeyPoint мне нужно знать информацию о размере в дополнение к местоположению в пикселях.

KeyPoint (Point2f _pt, float _size, float _angle=-1, float _response=0, int _octave=0, int _class_id=-1)

Кто-нибудь может сказать мне, какой размер в конструкторе? Нужна ли мне информация об углах для вычисления дескриптора просеивания? И как я могу рассчитать их с poencv3.

2 ответа

@Utkarsh: я согласен с тем фактом, что для дескриптора SIFT требуется информация об ориентации и масштабе ключевой точки. В оригинальной статье Дэвида Дж. Лоу (Отличительные особенности изображения из масштабно-инвариантных ключевых точек) говорится: "Для достижения неизменности ориентации координаты дескриптора и ориентации градиента поворачиваются относительно ориентации ключевой точки". в то время как информация о масштабе используется для выбора уровня размытия по Гауссу для изображения во время вычисления дескриптора.

Однако вопрос в этом посте касался вычисления дескриптора для данного пикселя. Обратите внимание, что данное местоположение пикселя не является SIFT Keypoint, рассчитанным с использованием желаемой процедуры. Поэтому информация об ориентации и масштабе в этом случае недоступна. Таким образом, код, упомянутый в предыдущем ответе, вычисляет дескриптор SIFT для заданного пикселя в масштабе по умолчанию (т.е. 1) и ориентации по умолчанию (без поворота градиентных ориентаций окрестности).

@Teng Long: С другой стороны, я думаю, что подход, который вы используете для сопоставления ключевых точек на двух изображениях (исходном и повернутом), несколько двусмыслен. Вы должны отдельно запустить обнаружение SIFT Keypoint на обоих изображениях и рассчитать их соответствующие дескрипторы отдельно. Затем вы можете использовать грубую силу, соответствующую этим двум наборам ключевых точек.

Следующий код вычисляет ключевые точки SIFT на изображении и его повернутой на 45 градусов версии, а затем вычисляет дескрипторы ключевых точек SIFT, используя сопоставление методом грубой силы.

# include "opencv2/opencv_modules.hpp"

# include "opencv2/core/core.hpp"

# include "opencv2/features2d/features2d.hpp"

# include "opencv2/highgui/highgui.hpp"

# include "opencv2/nonfree/features2d.hpp"

# include "opencv2\imgproc\imgproc.hpp"

# include <stdio.h>

using namespace cv;

int main( int argc, char** argv )

{

Mat img_1, img_2;

// Load image in grayscale format

img_1 = imread( "scene.jpg", CV_LOAD_IMAGE_GRAYSCALE );

// Rotate the input image without loosing the corners

Point center = Point(img_1.cols / 2, img_1.rows / 2);

double angle = 45, scale = 1;

Mat rot = getRotationMatrix2D(center, angle, scale);

Rect bbox = cv::RotatedRect(center, img_1.size(), angle).boundingRect();

rot.at<double>(0,2) += bbox.width/2.0 - center.x;

rot.at<double>(1,2) += bbox.height/2.0 - center.y;

warpAffine(img_1, img_2, rot, bbox.size());

// SIFT feature detector

SiftFeatureDetector detector;

std::vector<KeyPoint> keypoints_1, keypoints_2;

detector.detect( img_1, keypoints_1 );

detector.detect( img_2, keypoints_2 );

// Calculate descriptors

SiftDescriptorExtractor extractor;

Mat descriptors_1, descriptors_2;

extractor.compute( img_1, keypoints_1, descriptors_1 );

extractor.compute( img_2, keypoints_2, descriptors_2 );

// Matching descriptors using Brute Force

BFMatcher matcher(NORM_L2);

std::vector<DMatch> matches;

matcher.match(descriptors_1, descriptors_2, matches);

//-- Quick calculation of max and min distances between Keypoints

double max_dist = 0; double min_dist = 100;

for( int i = 0; i < descriptors_1.rows; i++ )

{ double dist = matches[i].distance;

if( dist < min_dist ) min_dist = dist;

if( dist > max_dist ) max_dist = dist;

}

// Draw only "good" matches (i.e. whose distance is less than 2*min_dist,

//-- or a small arbitary value ( 0.02 ) in the event that min_dist is very

//-- small)

std::vector< DMatch > good_matches;

for( int i = 0; i < descriptors_1.rows; i++ )

{ if( matches[i].distance <= max(2*min_dist, 0.02) )

{ good_matches.push_back( matches[i]); }

}

//-- Draw only "good" matches

Mat img_matches;

drawMatches( img_1, keypoints_1, img_2, keypoints_2,

good_matches, img_matches, Scalar::all(-1), Scalar::all(-1),

vector<char>(), DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS );

//-- Show detected matches

imshow( "Good Matches", img_matches );

waitKey(0);

return 0;

}

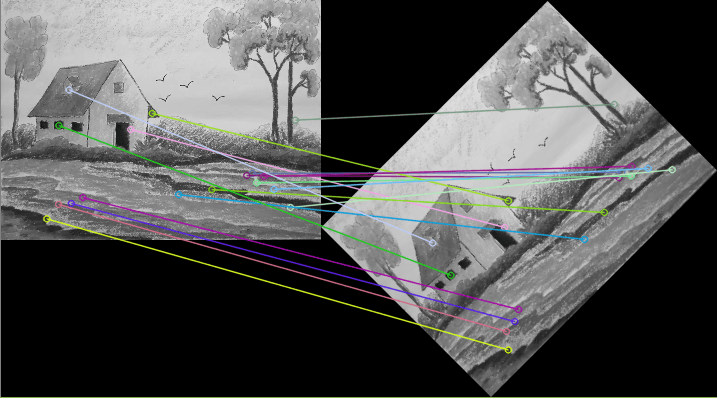

И вот результат: