neo4j-mazerunner, как увеличить объем памяти в docker-compose.yml

Используя kbastani/spark-neo4j с docker-compose на MacBook Pro (16 Гб памяти), я пытаюсь проанализировать strong_connected_components моего графика.

У меня есть график с около 60000 узлов (n1:Node {id:1})-[r:NEXT {count:100}]->(n2:Node {id:2}),

С помощью браузера neo4j мне удалось обработать pagerank обратно на мои узлы.

Однако, когда я пытаюсь запустить более сложный алгоритм, такой как strong_connected_components, я получаю следующую ошибку:

mazerunner_1 | 16/11/29 14:58:01 ERROR Utils: Uncaught exception in thread SparkListenerBus

mazerunner_1 | java.lang.OutOfMemoryError: Java heap space

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5$$anonfun$apply$9.apply(JobProgressListener.scala:200)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5$$anonfun$apply$9.apply(JobProgressListener.scala:200)

mazerunner_1 | at scala.collection.mutable.MapLike$class.getOrElseUpdate(MapLike.scala:189)

mazerunner_1 | at scala.collection.mutable.AbstractMap.getOrElseUpdate(Map.scala:91)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5.apply(JobProgressListener.scala:200)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5.apply(JobProgressListener.scala:198)

mazerunner_1 | at scala.collection.IndexedSeqOptimized$class.foreach(IndexedSeqOptimized.scala:33)

mazerunner_1 | at scala.collection.mutable.WrappedArray.foreach(WrappedArray.scala:34)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener.onJobStart(JobProgressListener.scala:198)

mazerunner_1 | at org.apache.spark.scheduler.SparkListenerBus$class.onPostEvent(SparkListenerBus.scala:34)

mazerunner_1 | at org.apache.spark.scheduler.LiveListenerBus.onPostEvent(LiveListenerBus.scala:31)

mazerunner_1 | at org.apache.spark.scheduler.LiveListenerBus.onPostEvent(LiveListenerBus.scala:31)

mazerunner_1 | at org.apache.spark.util.ListenerBus$class.postToAll(ListenerBus.scala:53)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus.postToAll(AsynchronousListenerBus.scala:36)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1$$anonfun$run$1.apply$mcV$sp(AsynchronousListenerBus.scala:76)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1$$anonfun$run$1.apply(AsynchronousListenerBus.scala:61)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1$$anonfun$run$1.apply(AsynchronousListenerBus.scala:61)

mazerunner_1 | at org.apache.spark.util.Utils$.logUncaughtExceptions(Utils.scala:1618)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1.run(AsynchronousListenerBus.scala:60)

mazerunner_1 | Exception in thread "SparkListenerBus" java.lang.OutOfMemoryError: Java heap space

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5$$anonfun$apply$9.apply(JobProgressListener.scala:200)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5$$anonfun$apply$9.apply(JobProgressListener.scala:200)

mazerunner_1 | at scala.collection.mutable.MapLike$class.getOrElseUpdate(MapLike.scala:189)

mazerunner_1 | at scala.collection.mutable.AbstractMap.getOrElseUpdate(Map.scala:91)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5.apply(JobProgressListener.scala:200)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener$$anonfun$onJobStart$5.apply(JobProgressListener.scala:198)

mazerunner_1 | at scala.collection.IndexedSeqOptimized$class.foreach(IndexedSeqOptimized.scala:33)

mazerunner_1 | at scala.collection.mutable.WrappedArray.foreach(WrappedArray.scala:34)

mazerunner_1 | at org.apache.spark.ui.jobs.JobProgressListener.onJobStart(JobProgressListener.scala:198)

mazerunner_1 | at org.apache.spark.scheduler.SparkListenerBus$class.onPostEvent(SparkListenerBus.scala:34)

mazerunner_1 | at org.apache.spark.scheduler.LiveListenerBus.onPostEvent(LiveListenerBus.scala:31)

mazerunner_1 | at org.apache.spark.scheduler.LiveListenerBus.onPostEvent(LiveListenerBus.scala:31)

mazerunner_1 | at org.apache.spark.util.ListenerBus$class.postToAll(ListenerBus.scala:53)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus.postToAll(AsynchronousListenerBus.scala:36)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1$$anonfun$run$1.apply$mcV$sp(AsynchronousListenerBus.scala:76)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1$$anonfun$run$1.apply(AsynchronousListenerBus.scala:61)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1$$anonfun$run$1.apply(AsynchronousListenerBus.scala:61)

mazerunner_1 | at org.apache.spark.util.Utils$.logUncaughtExceptions(Utils.scala:1618)

mazerunner_1 | at org.apache.spark.util.AsynchronousListenerBus$$anon$1.run(AsynchronousListenerBus.scala:60)

Я попытался изменить мой файл docker-compose.yml следующим образом:

hdfs:

environment:

- "JAVA_OPTS=-Xmx5g"

image: sequenceiq/hadoop-docker:2.4.1

command: /etc/bootstrap.sh -d -bash

mazerunner:

environment:

- "JAVA_OPTS=-Xmx5g"

image: kbastani/neo4j-graph-analytics:latest

links:

- hdfs

graphdb:

environment:

- "JAVA_OPTS=-Xmx2g"

image: kbastani/docker-neo4j:latest

ports:

- "7474:7474"

- "1337:1337"

volumes:

- /opt/data

links:

- mazerunner

- hdfs

без успеха. Как настроить spark & hdfs для использования максимально доступной памяти?

1 ответ

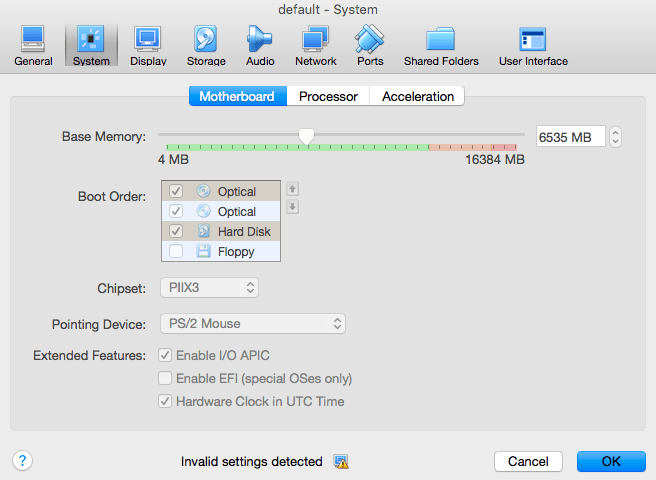

Моим решением было увеличение объема памяти виртуальной машины. В пользовательском интерфейсе Virtual Box я установил ползунок размера "Базовая память".