Запуск распределенного тензорного потока в синхронном SGD(BSP)

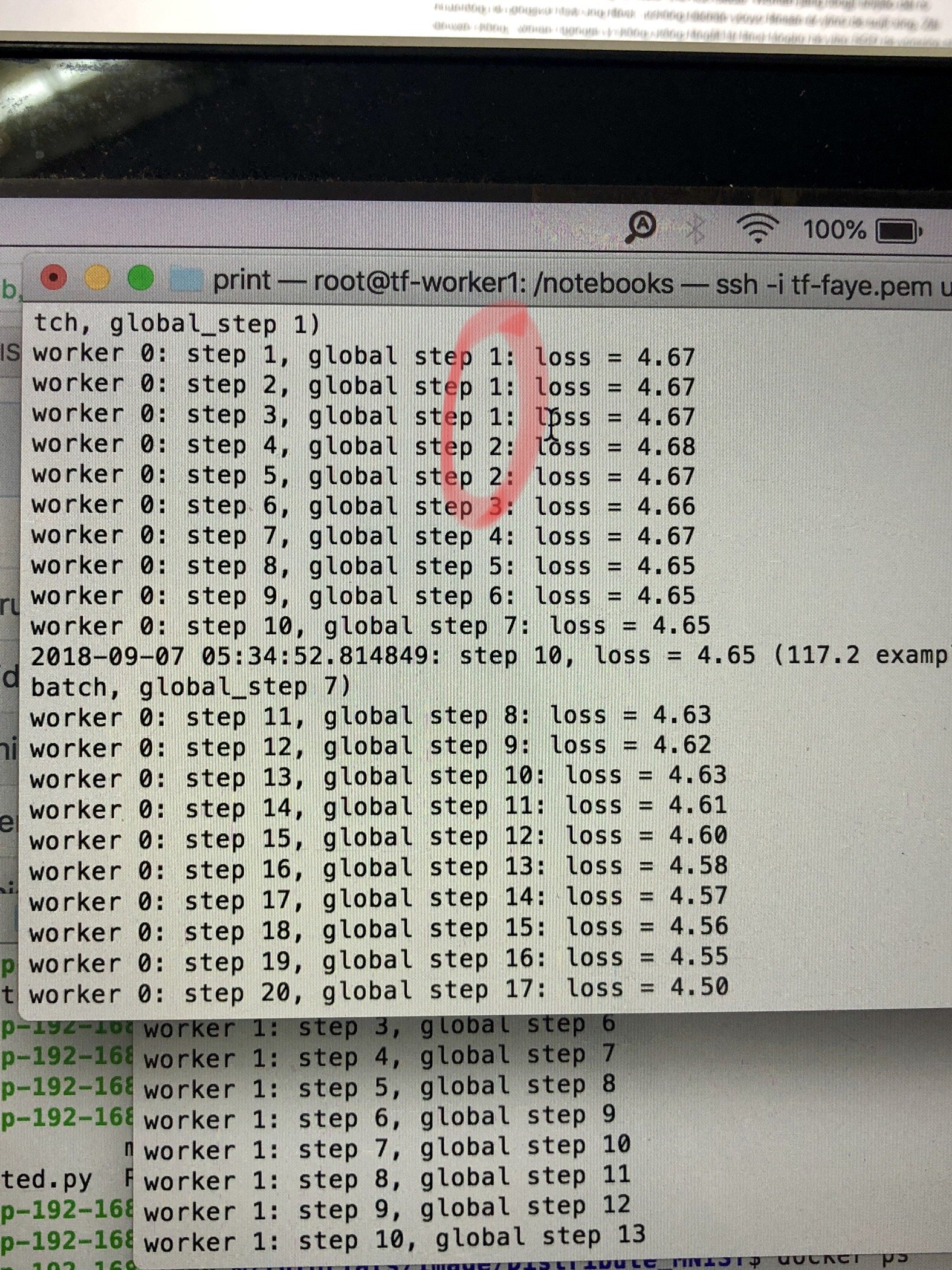

Я пытаюсь изменить код "cifar10_multi_gpu_train.py" в https://github.com/tensorflow/models/tree/master/tutorials/image/cifar10 для распределенного способа, чтобы я мог запустить его в кластере процессора. Я использую 2 рабочих и 1 пс в механизме BSP. Но результаты двух рабочих, похоже, не являются синхронными. Worker 1 не начал выполняться, пока Worker 0 уже не выполнил глобальный шаг 1 3 раза, а глобальный шаг 2 2 раза. Есть ли кто-нибудь, кто может помочь мне ответить на странное явление. Должны ли оба работника иметь одинаковые глобальные шаги в механизме BSP.

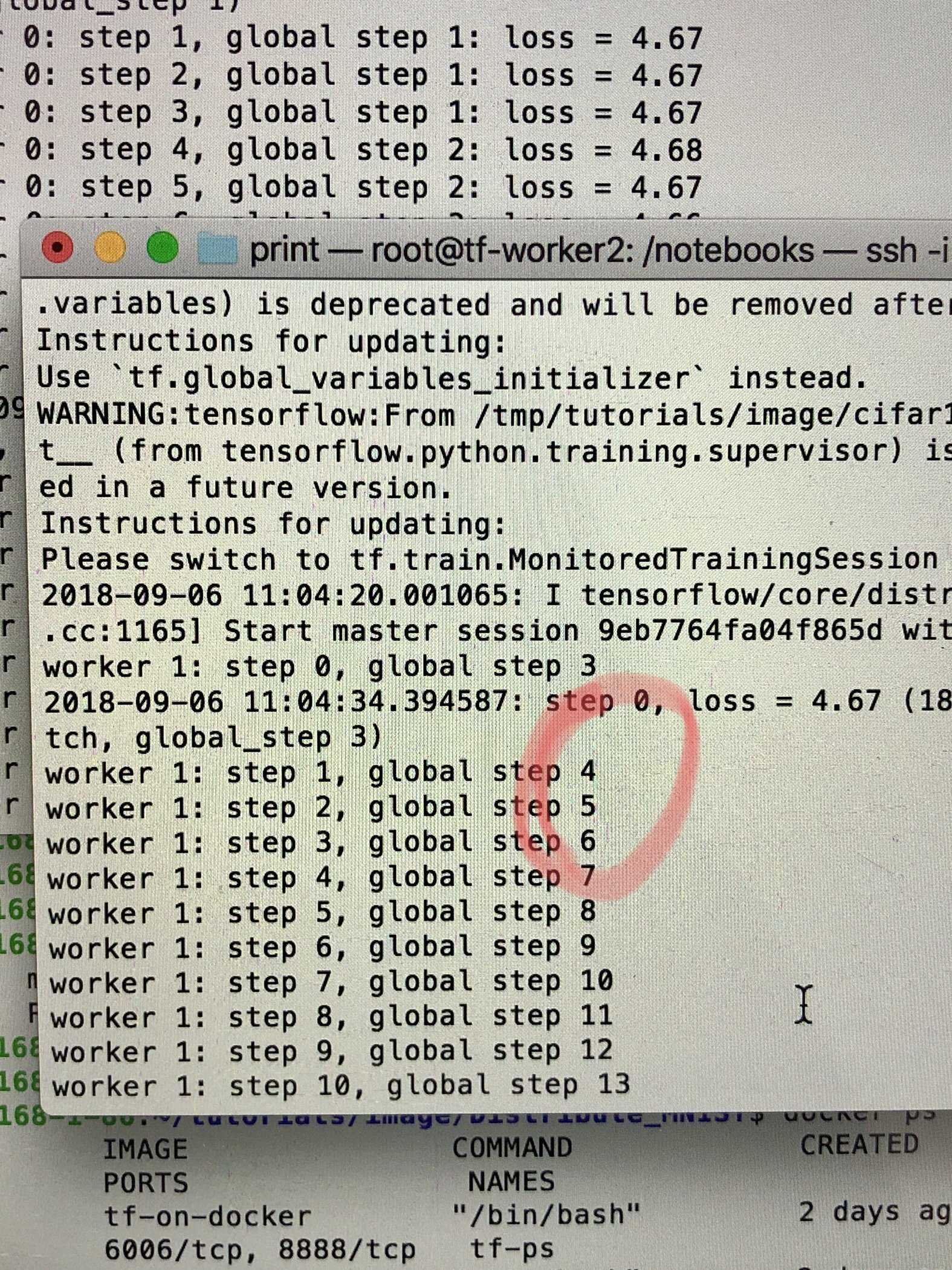

Результат работника 1: