Почему сканирование моих страниц в Google блокируется моим файлом robots.txt?

У меня двойной вопрос о количестве страниц, просканированных Google, и это может быть связано с возможным дублированием контента (или нет) и влиянием на SEO.

Факты о моем количестве страниц и страниц, просмотренных Google

Я запустил новый сайт два месяца назад. Сегодня в нем около 150 страниц (оно увеличивается с каждым днем). Это количество страниц в моем сайте в любом случае.

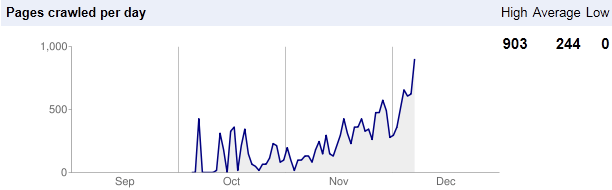

Если я посмотрю "Статистика сканирования" в веб-мастере Google, то увижу, что число страниц, сканируемых Google каждый день, намного больше (см. Изображение ниже).

Я не уверен, что это на самом деле хорошо, потому что он не только делает мой сервер немного более загруженным (загрузка 5,6 МБ для 903 страниц в день), но я боюсь, что он также создает некоторый дублирующий контент.

Я проверил в Google (site:mysite.com), и он дает мне 1290 страниц (но только 191 отображаются, если я не нажму "повторить поиск с пропущенными результатами". Давайте предположим, что 191 из них - те, которые есть в моей карте сайта) (Я думаю, что у меня проблема с дублирующимся содержимым около 40 страниц, но я просто обновляю сайт для этого).

Факты на моем robots.txt

Я использую файл robots.txt, чтобы запретить всем сканирующим движкам переходить на страницы с параметрами (см. Ниже роботы), а также с "Тегами".

User-Agent: *

Disallow: /administrator

Disallow: *?s

Disallow: *?r

Disallow: *?c

Disallow: *?viewmode

Disallow: */tags/*

Disallow: *?page=1

Disallow: */user/*

Наиболее важным является теги. Они в моем URL следующим образом:

www.mysite.com/tags/Advertising/writing

Он заблокирован файлом robots.txt (я проверял это у веб-мастера Google), но он все еще присутствует в поиске Google (но вам нужно нажать "повторить поиск с пропущенными результатами".)

Я не хочу, чтобы эти страницы сканировались, поскольку они дублируют содержимое (это своего рода поиск по ключевому слову), поэтому я помещаю их в файл robots.txt.

Наконец, мои вопросы:

Почему Google сканирует страницы, которые я заблокировал в robots.txt?

Почему Google индексирует страницы, которые я заблокировал? Считают ли эти страницы Google дублирующим контентом? Если да, я думаю, это плохо для SEO.

РЕДАКТИРОВАТЬ: Я не спрашиваю, как удалить страницы, проиндексированные в Google (я уже знаю ответ).

1 ответ

Почему Google сканирует страницы, которые я заблокировал в robots.txt? Почему Google индексирует заблокированные мной страницы?

Возможно, они просканировали его до того, как вы заблокировали его. Вам нужно подождать, пока они прочитают ваш обновленный файл robots.txt, а затем соответствующим образом обновить свой индекс. Для этого нет установленного расписания, но оно обычно дольше для новых сайтов.

Считаются ли эти страницы дублирующимся контентом?

Вы говорите нам. Дублированный контент - это когда две страницы имеют одинаковый или почти идентичный контент на двух или более страницах. Это происходит на вашем сайте?

Блокировка дублирующегося контента не способ решить эту проблему. Вы должны использовать канонические URL. Блокировка страниц означает, что вы ссылаетесь на "черные дыры" на своем веб-сайте, что вредит вашим усилиям по SEO. Канонические URL-адреса предотвращают это и дают каноническим URL-адресам полную ссылку на соответствующие термины и все ссылки на все дублированные страницы.