Некоторые идеи и указания, как измерить рейтинг, AP, MAP, отзыв для оценки IR

У меня есть вопрос о том, как оценить результат получения информации, хорошо это или нет, например, рассчитать

Соответствующий документ звание, отзыв, точность,AP, MAP.....

В настоящее время система может извлечь документ из базы данных, как только пользователь введет запрос. Проблема в том, что я не знаю, как сделать оценку.

Я получил некоторый общедоступный набор данных, такой как ссылка на набор данных"Коллекция Крэнфилда", которая в нем содержится

1. документ 2. запрос 3. релевантные оценки

DOCS QRYS SIZE*

Cranfield 1,400 225 1.6

Могу ли я узнать, как использовать оценку с помощью "Коллекции Крэнфилда" для расчета ранга соответствующего документа, отзыва, точности,AP, MAP.....

Мне могут понадобиться некоторые идеи и указания. не спрашивая, как закодировать программу.

2 ответа

Рейтинг документов

Okapi BM25 (BM обозначает Best Matching) - это функция ранжирования, используемая поисковыми системами для ранжирования соответствующих документов в соответствии с их релевантностью для данного поискового запроса. Он основан на вероятностной структуре поиска. BM25 - это функция поиска пакета слов, которая ранжирует набор документов на основе условий запроса, появляющихся в каждом документе, независимо от взаимосвязи между условиями запроса в документе (например, их относительная близость). Смотрите страницу Википедии для более подробной информации.

Точность и отзыв

Точные меры "из всех документов, которые мы извлекли как релевантные, сколько из них действительно актуально?".

Precision = No. of relevant documents retrieved / No. of total documents retrieved

Напомним меры "Из всех актуальных релевантных документов, сколько мы извлекли как релевантные?".

Recall = No. of relevant documents retrieved / No. of total relevant documents

Предположим, что когда запрос "q" передается в информационно-поисковую систему (например, поисковую систему), имеющую 100 релевантных документов по запросу "q", система извлекает 68 документов из общего собрания из 600 документов. Из 68 найденных документов 40 документов были актуальны. Итак, в этом случае:

Precision = 40 / 68 = 58.8% а также Recall = 40 / 100 = 40%

F-Score / F-measure - взвешенное гармоническое среднее точности и отзыва. Традиционная F-мера или сбалансированная F-оценка:

F-Score = 2 * Precision * Recall / Precision + Recall

Средняя точность

Вы можете думать об этом так: вы вводите что-то в Google и он показывает вам 10 результатов. Вероятно, было бы лучше, если бы все они были актуальны. Если только некоторые из них релевантны, скажем, пять из них, то гораздо лучше, если соответствующие показываются первыми. Было бы плохо, если бы первые пять не имели значения, а хорошие начинались только с шестого, не так ли? Оценка AP отражает это.

Приведу пример ниже:

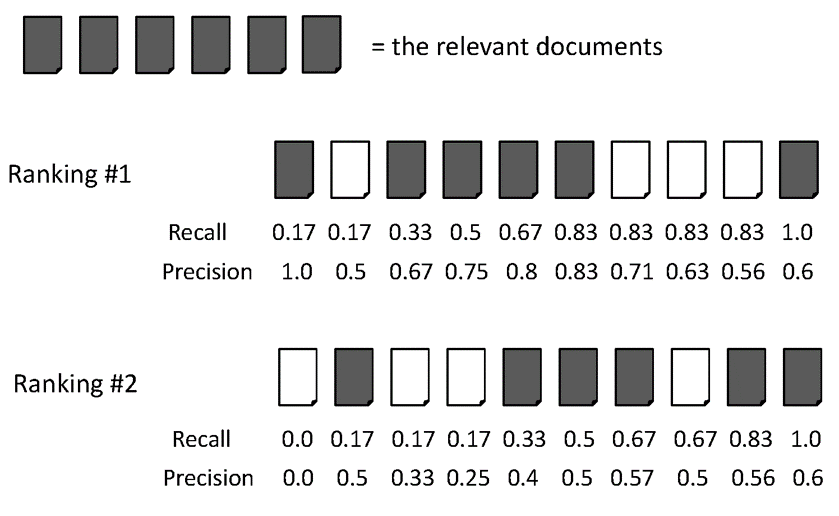

AvgPrec из двух рейтингов:

Рейтинг № 1: (1.0 + 0.67 + 0.75 + 0.8 + 0.83 + 0.6) / 6 = 0.78

Рейтинг № 2: (0.5 + 0.4 + 0.5 + 0.57 + 0.56 + 0.6) / 6 = 0.52

Средняя средняя точность (MAP)

MAP - это среднее значение средней точности для нескольких запросов / рейтингов. Приведу пример для иллюстрации.

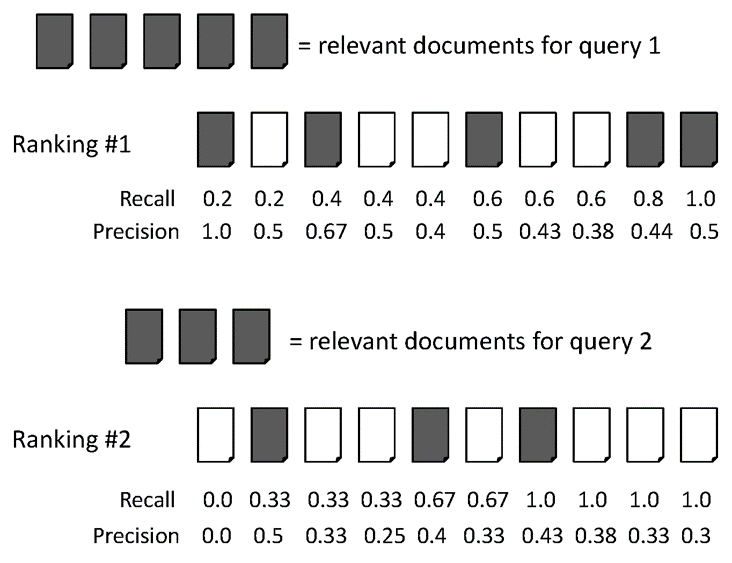

Средняя средняя точность для двух запросов:

Для запроса 1 AvgPrec: (1.0+0.67+0.5+0.44+0.5) / 5 = 0.62

Для запроса 2 AvgPrec: (0.5+0.4+0.43) / 3 = 0.44

Итак, MAP = (0.62 + 0.44) / 2 = 0.53

Иногда люди используют precision@k, recall@k в качестве показателя эффективности поисковой системы. Вы должны построить поисковую систему для таких испытаний. Если вы хотите написать свою программу на Java, вам следует подумать об Apache Lucene для создания своего индекса.

Расчет точности и отзыв прост; Точность - это доля соответствующих извлеченных документов во всех найденных вами документах. Напомним, это доля соответствующих документов, извлеченных из всех соответствующих документов.

Например, если у запроса есть 20 релевантных документов, и вы получили 25 документов, из которых только 14 относятся к запросу, то: Precision = 14/25 и Recall = 14/20.

Но точность и отзыв должны сочетаться таким образом, который называется F-Measure и является гармоническим средним значением точности и отзыва: F-Score = 2 * Precision * Recall / Precision + Recall.

AP сообщает вам соотношение соответствующих документов с не относящимися к делу документами в определенном количестве найденных документов. Предположим, вы получили 25 документов, а в первых 10 документах - 8 соответствующих документов. Итак, AP(10) = 8/10;

Если вы рассчитываете и добавляете AP для 1 к N, а затем делите его на N, вы только что рассчитали MAP. Где N - общее количество соответствующих документов в наборе данных за год.