Модель GGUF работает медленнее по сравнению с GGMLv3, основанной на той же базовой модели.

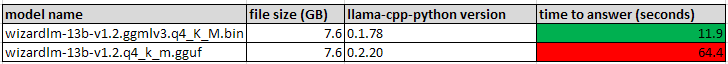

Я сравниваю производительность двух экземпляров модели Wizardlm-13b, которую я скачал с HuggingFace. Я обнаружил, что версия модели GGUF работает в 4 раза медленнее, чем версия GGMLv3. Насколько я могу судить, это обе 4-битные квантованные модели, полученные на основе одной базовой модели.

Я создал вывод для обеих моделей, используя пакет llama-cpp-python.

Я использовал следующий код для оценки производительности:

from llama_cpp import Llama

llm = Llama(model_path="./models/7B/llama-model.gguf")

output = llm("Q: Name all of the planets in the solar system? A: ", max_tokens=64, stop=["Q:", "\n"], echo=True)

print(output)

И вот результаты, работающие на моем процессоре:

Аналогичные различия в производительности я видел и при работе на графическом процессоре.

Я пытаюсь понять, что может быть основной причиной таких различий в производительности. Ожидается ли, что GGUF будет работать медленнее, чем GGMLv3? Возможно ли, что новая версия llama-cpp-python может вызвать разницу? Или, может быть, я что-то еще упускаю из виду?