Как ограничить поиск вне контекста в LangChain

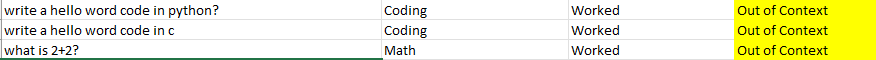

Я хочу ограничить поиск по запросам специальными документами для LLM. но результаты отображаются вне контекста, как показано на изображении ниже.

для генерации токенов

max_input_size = 4096

num_outputs = 512

max_chunk_overlap = 20

chunk_size_limit = 600

gpt_model_name='text-davinci-003'

prompt_helper = PromptHelper(max_input_size, num_outputs, max_chunk_overlap, chunk_size_limit=chunk_size_limit)

llm_predictor = LLMPredictor(llm=OpenAI(temperature=0, model_name=gpt_model_name, max_tokens=num_outputs))

documents = SimpleDirectoryReader('./static/').load_data()

index = GPTSimpleVectorIndex(documents, llm_predictor=llm_predictor, prompt_helper=prompt_helper)

index.save_to_disk('./static/dump/story.json')

Для запроса:

new_index = GPTSimpleVectorIndex.load_from_disk('./static/dump/story.json')

response = new_index.query("Only answer from provided content:"+ques,response_mode="compact")

Поскольку я новичок в этом деле, буду благодарен за любую помощь.