Apache Nifi - потребляйте Kafka + объединяйте контент + ставьте HDFS, чтобы избежать мелких файлов

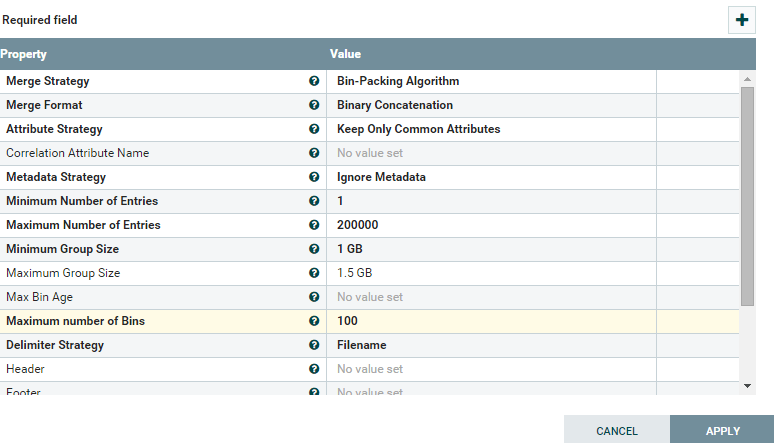

У меня около 2000000 сообщений в теме Кафки, и я хочу поместить эти записи в HDFS, используя NiFi, поэтому я использую PutHDFS процессор для этого вместе с ConsumeKafka_0_10 но он генерирует небольшие файлы в HDFS, поэтому я использую процессор слияния контента для объединения записей перед отправкой файла.  Пожалуйста, помогите, если конфигурация нуждается в изменениях. Это прекрасно работает для небольшого количества сообщений, но записывает один файл для каждой записи, когда речь идет о темах с большими объемами данных.

Пожалуйста, помогите, если конфигурация нуждается в изменениях. Это прекрасно работает для небольшого количества сообщений, но записывает один файл для каждой записи, когда речь идет о темах с большими объемами данных.

Спасибо!!

1 ответ

Решение

Минимальное количество записей установлено равным 1, что означает, что оно может иметь значение от 1 до максимального количества записей. Попробуйте сделать что-то выше, например, 100 КБ.