Как уменьшить запрос ресурсов диска istio-proxy на GKE + ASM?

Я запускаю кластер GKE Autopilot с функцией ASM.

Кластер предназначен для среды разработки, поэтому я хочу максимально снизить стоимость обслуживания.

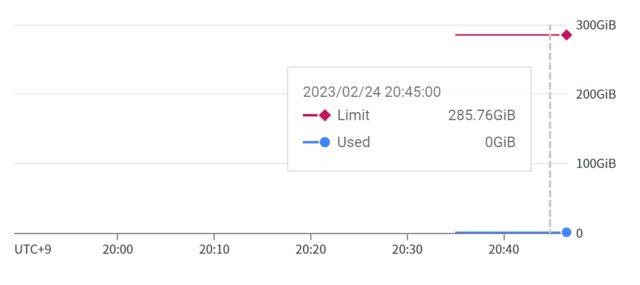

Благодаря включению каждый модуль в кластере имеетistio-proxyно прокси-сервер запрашивает почти 300 ГБ диска, даже если для модуля (отget pod -o yaml) запросить 1 ГБ или около того.

kubectl get pod <pod-name> -o yaml

...

resources:

limits:

cpu: 250m

ephemeral-storage: 1324Mi

memory: 256Mi

requests:

cpu: 250m

ephemeral-storage: 1324Mi

memory: 256Mi

...

Нужен ли для запуска ASM почти 300-гигабайтный запрос на диск? Или я могу уменьшить это?

[отредактировано 01 марта 2023 г.]

Чтобы воспроизвести это, разверните приведенный ниже yaml в кластере GKE с помощью ASM. В этом случае пространство имен по умолчанию должно быть помечено для использования

istio-injection.

apiVersion: v1

kind: Service

metadata:

labels:

app: nginx-test

service: nginx-test

name: nginx-test

spec:

ports:

- name: http

port: 80

selector:

app: nginx-test

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx-test

name: nginx-test

spec:

replicas: 1

selector:

matchLabels:

app: nginx-test

template:

metadata:

labels:

app: nginx-test

annotations:

sidecar.istio.io/proxyCPU: 250m

sidecar.istio.io/proxyMemory: 256Mi

spec:

containers:

- image: nginx

imagePullPolicy: IfNotPresent

name: nginx-test

ports:

- containerPort: 80