Учитывая количество параметров, как оценить объем VRAM, необходимый для модели pytorch?

Я пытаюсь оценить объем VRAM, необходимый для полностью подключенной модели, без необходимости создавать / обучать модель в pytorch.

Я довольно близко подошел к этой формуле:

# params = number of parameters

# 1 MiB = 1048576 bytes

estimate = params * 24 / 1048576

В этом примере модели есть 384048000 параметров, но я тестировал это на разных моделях с разными размерами параметров.

Результаты довольно точные. Однако при оценке учитывается только VRAM сеанса pytorch, а не объем VRAM в драйвере / буфере cuda. Вот примерные (с формулой) и эмпирические результаты (с использованием nvidia-smi после построения / обучения модели)

ESTIMATE BEFORE EMPIRICAL TEST:

VRAM estimate = 8790.1611328125MiB

EMPIRICAL RESULT AFTER BUILDING MODEL:

GPU RAM for pytorch session only (cutorch.max_memory_reserved(0)/1048576): 8466.0MiB

GPU RAM including extra driver buffer from nvidia-smi: 9719MiB

Есть идеи, как оценить эту дополнительную VRAM, отображаемую в выводе nvidia-smi?

1 ответ

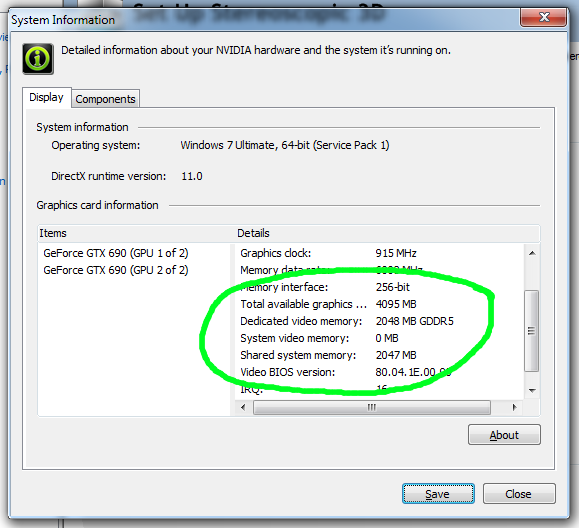

Окна:

- Щелкните правой кнопкой мыши на рабочем столе и выберите Панель управления NVIDIA.

- Перейдите в меню Help -> System Information.

- Посмотрите видеопамять на вкладке «Дисплей» в списке «Подробности».