Изменения в модели GPT2/GPT3 во время обучения с несколькими выстрелами

Во время трансферного обучения мы берем предварительно обученную сеть и некоторую пару наблюдений (ввод и метку) и используем эти данные для точной настройки веса с помощью обратного распространения ошибки. Однако во время обучения одним или несколькими выстрелами, согласно этой статье - «Языковые модели - немногие изучающие» (https://arxiv.org/pdf/2005.14165.pdf), «Обновление градиента не выполняется». Тогда какие изменения происходят с такими моделями, как GPT2 и GPT3, во время обучения по принципу «один выстрел / несколько кадров»?

3 ответа

Формулировку можно было бы улучшить. «Многоэтапное обучение» — это метод, который предполагает обучение модели на небольшом объеме данных, а не на большом наборе данных. Этот тип обучения не требует обновлений градиента, которые обычно используются в традиционных алгоритмах машинного обучения. GPT-x способен генерировать текст, похожий на человеческий, предсказывая следующее слово или последовательность слов на основе предоставленного контекста. Однако его основная функция — дополнять текст на основе подсказки ввода, а не учиться с нуля.

Чтобы эффективно использовать GPT-3, вы можете создать приглашение для ввода, включающее четкий контекст и любую соответствующую информацию. Например:

Человек: Привет, дружелюбный ИИ. Дружественный AI: Здравствуйте, я готов вам помочь. Человек: $user_prompt

Затем вы можете вставить приглашение пользователя в $user_prompt и позволить GPT-3 сгенерировать полный ответ на основе контекста и понимания языка.

Тогда какие изменения происходят с такими моделями, как GPT2 и GPT3, во время обучения по принципу «один выстрел / несколько кадров»?

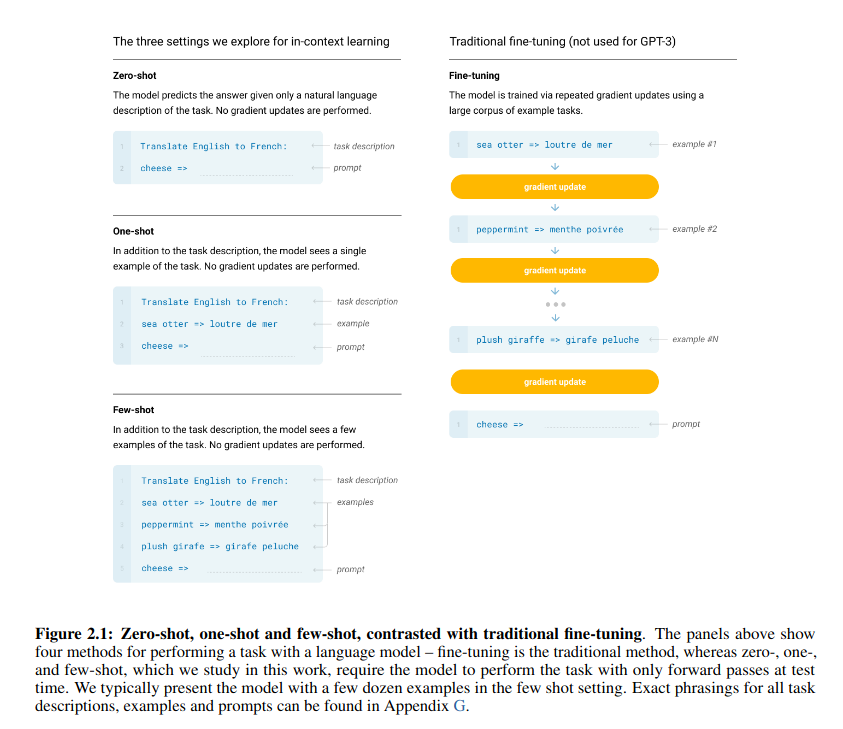

Никаких изменений в модели нет. Модель ничего консервативно не узнает. Что они делают, так это предоставляют «обучающие примеры» в качестве контекста модели, и модель генерирует выходные данные в конце этого контекста. На рис. 2.1 (Браун, Том Б. и др. «Языковые модели изучаются по малому кругу» (2020).) Показаны примеры входных данных для точной настройки, обучения с нулевым выстрелом и обучения с несколькими выстрелами.

Как видите, обучающие примеры являются частью входных данных, и их нужно давать каждый раз, когда нужно делать прогноз. Поэтому никаких изменений в модели не произошло.  Браун, Том Б. и др. «Языковые модели - малоизученные». (2020)

Браун, Том Б. и др. «Языковые модели - малоизученные». (2020)

Вы можете подумать, что есть некоторые изменения, потому что модель дает лучшие результаты в случае обучения с несколькими выстрелами. Однако это та же модель, но с другим контекстом в качестве входных данных. GPT-2 и GPT-3 являются авторегрессивными моделями, что означает, что результат также зависит от контекста. Больше примеров означало бы более ясный контекст, и, таким образом, шанс получить желаемые результаты увеличивается.