Настройте Apache KAFKA с внешними и внутренними слушателями и аутентификацией SASL для внешней публикации / подписки

Я хочу настроить аутентификацию Kafka (сейчас только аутентификация, шифрование не требуется), используя 2 слушателя:

- один для частного общения между брокерами с безопасностью PLAINTEXT

- один для публичного общения потребителей / производителей с SASL_PLAINTEXT и SCRAM-SHA-256

У меня один кластер Kafka только с одним брокером (для целей тестирования) и кластер Zookeeper с двумя узлами

Я сделал следующие шаги:

- Создайте пользователей с правами администратора и тестового пользователя в zookeeper

kafka-configs.sh --zookeeper zk:2181 --alter --add-config 'SCRAM-SHA-256=[iterations=8192,password=test-secret]' \

--entity-type users --entity-name test-user

kafka-configs.sh --zookeeper zk:2181 --alter --add-config 'SCRAM-SHA-256=[password=admin-secret]' \

--entity-type users --entity-name admin

- настройте свойства сервера следующим образом:

############################# Server Basics #############################

broker.id=1

############################# Socket Server Settings #############################

listeners=EXTERNAL://0.0.0.0:9095,INTERNAL://:9092

advertised.listeners=EXTERNAL://172.20.30.40:9095,INTERNAL://:9092

listener.security.protocol.map=INTERNAL:PLAINTEXT, EXTERNAL:SASL_PLAINTEXT

inter.broker.listener.name=INTERNAL

sasl.mechanism.inter.broker.protocol=SCRAM-SHA-256

sasl.enabled.mechanisms=PLAIN, SCRAM-SHA-256

num.network.threads=3

num.io.threads=8

socket.send.buffer.bytes=102400

socket.receive.buffer.bytes=102400

socket.request.max.bytes=104857600

############################# Log Basics #############################

log.dirs=/opt/kafka/logs

num.partitions=1

num.recovery.threads.per.data.dir=1

delete.topic.enable=false

auto.create.topics.enable=true

default.replication.factor=1

############################# Log Flush Policy #############################

#log.flush.interval.messages=10000

#log.flush.interval.ms=1000

############################# Log Retention Policy #############################

log.retention.hours=168

#log.retention.bytes=1073741824

log.segment.bytes=1073741824

log.retention.check.interval.ms=300000

log.cleaner.enable=true

############################# Offset Retention #############################

offsets.retention.minutes=1440

############################# Connect Policy #############################

zookeeper.connect=10.42.203.74:2181,10.42.214.116:2181

zookeeper.connection.timeout.ms=6000

- создайте файл kafka_server_jaas.conf и передайте его kafka во время загрузки с помощью -Djava.security.auth.login.config=/opt/kafka/config/kafka_server_jaas.conf

internal.KafkaServer {

org.apache.kafka.common.security.plain.PlainLoginModule required

username="admin"

password="admin-secret";

};

external.KafkaServer {

org.apache.kafka.common.security.scram.ScramLoginModule required;

};

- создать тестовую тему для публикации / подписки

kafka-topics.sh --create --zookeeper zk:2181 --replication-factor 1 --partitions 3 --topic test-topic

- создайте файл client-secure.properties для публикации с использованием тестового пользователя и его учетных данных:

sasl.jaas.config=org.apache.kafka.common.security.scram.ScramLoginModule required \

username="test-user" \

password="test-secret";

security.protocol=SASL_PLAINTEXT

sasl.mechanism=SCRAM-SHA-256

- и, наконец, попробуйте опубликовать с помощью ВНЕШНЕГО слушателя в ранее созданную тестовую тему с аутентификацией с помощью тестового пользователя.

kafka-console-producer.sh --broker-list 172.20.30.40:9095 --topic test-topic

--producer.config client-secure.properties

и я всегда получаю следующую ошибку:

ERROR [Producer clientId=console-producer] Connection to node -1 failed authentication due to:

Client SASL mechanism 'SCRAM-SHA-256' not enabled in the server, enabled mechanisms are [PLAIN]

(org.apache.kafka.clients.NetworkClient)

почему на сервере не включен механизм SCRAM-SHA-256? не следует ли его включать с помощью свойства sasl.enabled.mechanisms=PLAIN, SCRAM-SHA-256 в файле server.properties и конфигурации scram в конфигурации внешнего прослушивателя, определенной в файле kafka_server_jaas.conf?

Я уже 2 дня подряд борюсь с этим, применяя разные конфигурации без особого успеха. Любая помощь будет очень признательна

заранее спасибо

1 ответ

После нескольких дней борьбы с этим я нашел решение.

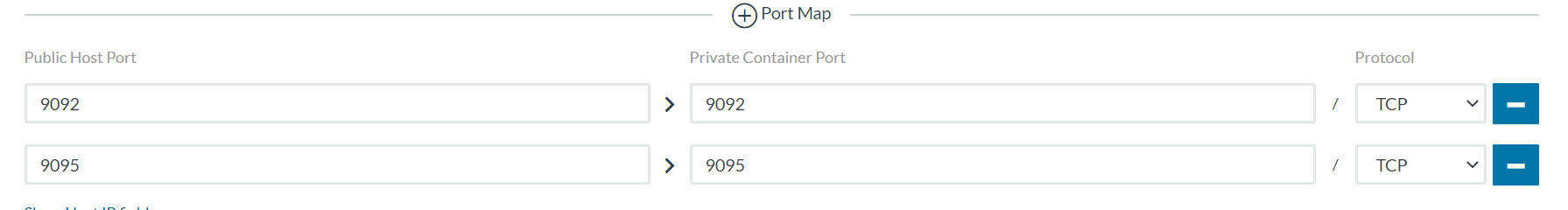

Я не упомянул в сообщении, что я запускаю KAFKA в качестве контейнера в Rancher, а порт 9095 EXTERNAL listener не был отображен в Rancher, поэтому его также не было в контейнере докеров.

Хотя я проводил тесты изнутри контейнера, если порт слушателя, на который вы публикуете / подписываете, не отображается, это не работает.