Как настроить spark.task.maxFailures на базе данных AWS?

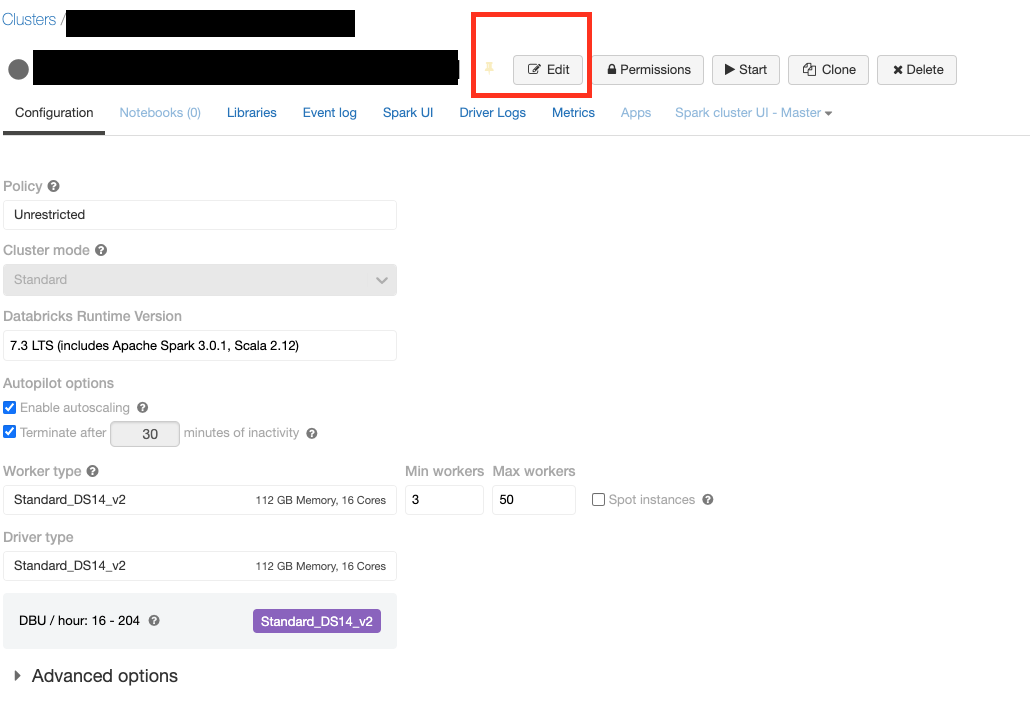

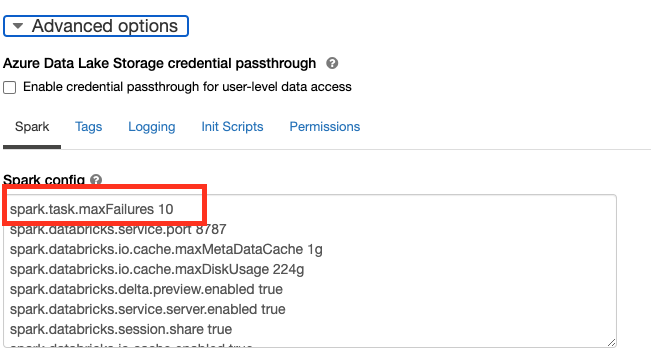

Я хотел бы установить для spark.task.maxFailures значение больше 4. Как я могу установить это значение в среде выполнения Databricks 6.4?

Когда я выполняю spark.conf.get("spark.task.maxFailures"), я получаю ошибку ниже

java.util.NoSuchElementException: spark.task.maxFailures

Кто-нибудь раньше ставил это на датабрик?

Я понимаю, что могу настроить его, используя

spark.conf.set("spark.task.maxFailures", 10)

однако не уверены, нужно ли это настраивать во время запуска кластера или можно установить после этого?

1 ответ

2021-12-06 20:15