Ошибка spark-submit: недопустимый максимальный размер кучи: -Xmx4g--jars, но в системе достаточно памяти

Я запускаю искровую работу:

spark-submit --master spark://ai-grisnodedev1:7077 --verbose --conf spark.driver.port=40065 --driver-memory 4g

--jars /opt/seqr/.conda/envs/py37/lib/python3.7/site-packages/hail/hail-all-spark.jar

--conf spark.driver.extraClassPath=/opt/seqr/.conda/envs/py37/lib/python3.7/site-packages/hail/hail-all-spark.jar

--conf spark.executor.extraClassPath=./hail-all-spark.jar ./hail_scripts/v02/convert_vcf_to_hail.py ./hgmd_pro_2019.4_hg38.vcf -ht

--genome-version 38 --output ./hgmd_pro_2019.4_hg38.ht

И команда выдает ошибку:

Недопустимый максимальный размер кучи: -Xmx4g --jars Ошибка: не удалось создать виртуальную машину Java. Ошибка: возникла фатальная исключительная ситуация. Программа будет закрыта.

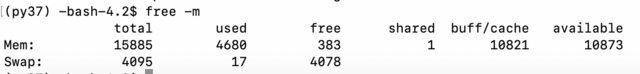

Проверил память:

Так что вроде нормально. Я проверилjava:

(py37) -bash-4.2$ java -version

openjdk version "1.8.0_232"

OpenJDK Runtime Environment (build 1.8.0_232-b09)

OpenJDK 64-Bit Server VM (build 25.232-b09, mixed mode)

Затем я зарегистрировался Chrome будь то spark работает на ai-grisnodedev1:7077и это с одним рабочим. Если я используюipython Я могу запустить простой installпример на https://hail.is/docs/0.2/getting_started.html:

import hail as hl

mt = hl.balding_nichols_model(n_populations=3, n_samples=50, n_variants=100)

mt.count()

Так, Hail это в зависимости от Sparkтоже работает. Может быть, моя команда искажена или некоторые файлы повреждены? S Но тогда ошибка вводит в заблуждение. Что я мог сделать, чтобы попытаться устранить эту проблему?

2 ответа

Просто разместил вопрос и сразу исправил, хотя был в довольно отчаянии. Проблема заключалась в том, что я копировал вставку команды в нескольких редакторах и обратно, и некоторые неправильные символы, вероятно, присутствовали после--driver-memory 4g. Я просто удалил пробелы (которые могли не быть пробелами) и снова вставил их, и все заработало. Это осколок, чтобы сказать, почему, может бытьtab или newlineкак-то все испортил. Я использовалMicrosoft One Note - может быть, он делает какие-то модификации пространств...

У меня тоже была проблема. Во всяком случае, я использовал

pySpark. Для меня проблема заключалась в том, что

spark.executor.memory принято например

16gb, в то время как

spark.driver.memoryтолько принято

16g-> Буква b в g b вызвала ошибку (немного неинтуитивно, если честно).