Снижение (по сравнению с задержкой) переобучения в нейронной сети

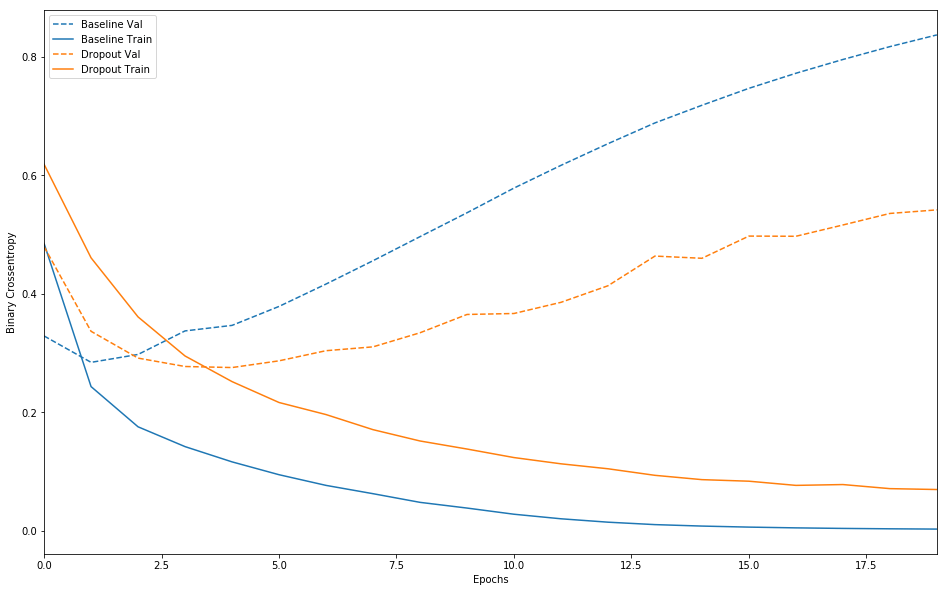

В нейронных сетях регуляризация (например, L2, выпадение) обычно используется для уменьшения переобучения. Например, на графике ниже показаны типичные потери в зависимости от эпохи с отсечкой и без нее. Сплошные линии = поезд, пунктир = проверка, синий = базовая линия (без выпадения), оранжевый = с выпадением. Сюжет любезно предоставлен учебниками Tensorflow.

Регуляризация веса ведет себя аналогичным образом.

Регуляризация веса ведет себя аналогичным образом.

Регуляризация задерживает эпоху, в которой потери при проверке начинают расти, но регуляризация, очевидно , не уменьшает минимальное значение потерь при проверке (по крайней мере, в моих моделях и в учебнике, из которого взят приведенный выше график).

Если мы используем раннюю остановку, чтобы остановить обучение, когда потеря валидации минимальна (чтобы избежать переобучения), и если регуляризация только задерживает точку минимальной потери валидации (по сравнению с уменьшением минимального значения потери валидации), то кажется, что регуляризация не приводит к сети с большим обобщением, а скорее просто замедляет обучение.

Как можно использовать регуляризацию для уменьшения минимальных потерь при проверке (для улучшения обобщения модели), а не просто откладывать ее? Если регуляризация только задерживает минимальные потери при проверке, но не снижает их, то зачем ее использовать?

1 ответ

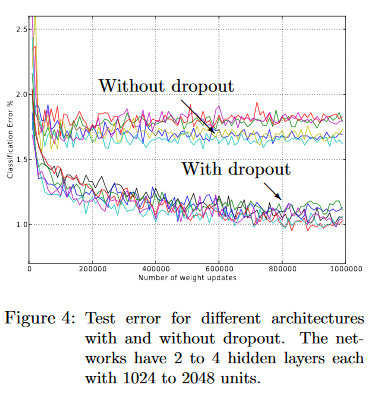

Возможно, чрезмерное обобщение одного учебного сюжета - не лучшая идея; вот соответствующий сюжет из оригинальной статьи об отсеве:

Ясно, что если эффект отсева приведет к задержке сходимости, от этого будет мало пользы. Но, конечно, это не всегда работает (как ясно видно из вашего сюжета), поэтому его не следует использовать по умолчанию (что, возможно, является уроком здесь)...