Уменьшайте убытки, а затем прыгайте RoBERTa

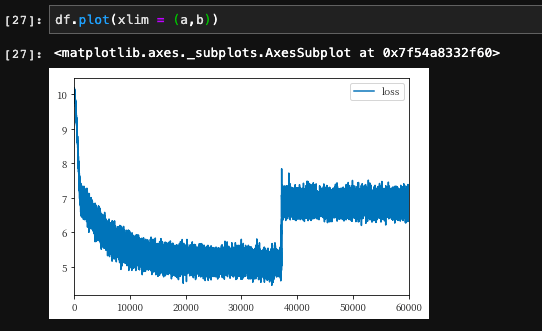

Я пытаюсь предварительно обучить модель RoBERTa, используя huggingface и свой собственный файл словаря. Я распечатал потери для каждой партии и вижу, как в первую эпоху потери уменьшаются, а затем переходят / сходятся при более высоком значении. Мне интересно, может ли кто-нибудь дать мне некоторое представление о том, почему это произошло.

Я пробовал использовать разные этапы разминки / тренировки (расписание), разную скорость обучения, разный размер пакета и разный размер обучающих данных. Я также перетасовывал набор данных перед каждым запуском.