Airflow не распознает мои настройки подключения S3

Я использую Airflow с исполнителем Kubernetes и тестирую его локально (используя minikube). Хотя мне удалось его запустить и запустить, я не могу хранить свои журналы в S3. Я пробовал все описанные решения, но все еще получаю следующую ошибку:

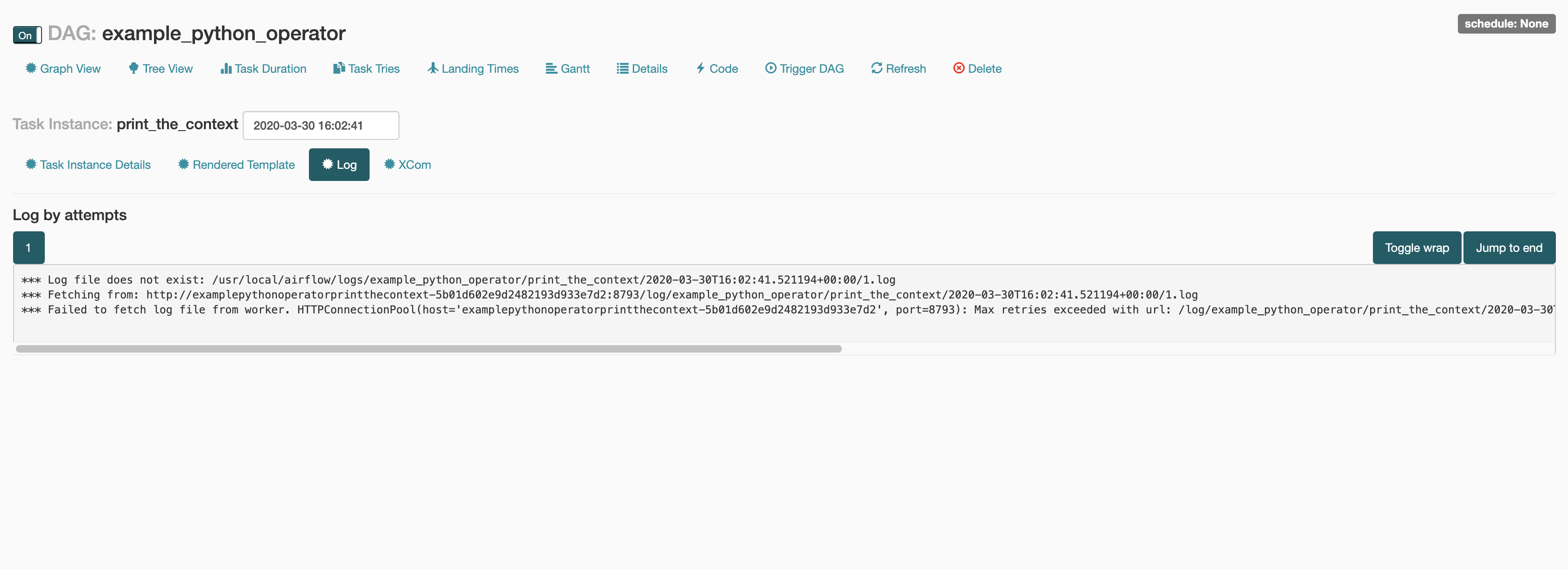

*** Log file does not exist: /usr/local/airflow/logs/example_python_operator/print_the_context/2020-03-30T16:02:41.521194+00:00/1.log

*** Fetching from: http://examplepythonoperatorprintthecontext-5b01d602e9d2482193d933e7d2:8793/log/example_python_operator/print_the_context/2020-03-30T16:02:41.521194+00:00/1.log

*** Failed to fetch log file from worker. HTTPConnectionPool(host='examplepythonoperatorprintthecontext-5b01d602e9d2482193d933e7d2', port=8793): Max retries exceeded with url: /log/example_python_operator/print_the_context/2020-03-30T16:02:41.521194+00:00/1.log (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7fd00688a650>: Failed to establish a new connection: [Errno -2] Name or service not known'))

Я реализовал собственный класс ведения журнала, как упоминалось в этом ответе, и все равно не повезло.

- Я использую Puckel Airflow 1.10.9

- Таблица Stable Helm для потока воздуха из диаграмм / стабильный / воздушный поток /

Мой airflow.yaml выглядит так

airflow:

image:

repository: airflow-docker-local

tag: 1

executor: Kubernetes

service:

type: LoadBalancer

config:

AIRFLOW__CORE__EXECUTOR: KubernetesExecutor

AIRFLOW__CORE__TASK_LOG_READER: s3.task

AIRFLOW__CORE__LOAD_EXAMPLES: True

AIRFLOW__CORE__FERNET_KEY: ${MASKED_FERNET_KEY}

AIRFLOW__CORE__SQL_ALCHEMY_CONN: postgresql+psycopg2://postgres:airflow@airflow-postgresql:5432/airflow

AIRFLOW__CELERY__RESULT_BACKEND: db+postgresql://postgres:airflow@airflow-postgresql:5432/airflow

AIRFLOW__CELERY__BROKER_URL: redis://:airflow@airflow-redis-master:6379/0

# S3 Logging

AIRFLOW__CORE__REMOTE_LOGGING: True

AIRFLOW__CORE__REMOTE_LOG_CONN_ID: s3://${AWS_ACCESS_KEY_ID}:${AWS_ACCESS_SECRET_KEY}@S3

AIRFLOW__CORE__REMOTE_BASE_LOG_FOLDER: s3://${BUCKET_NAME}/logs

AIRFLOW__CORE__S3_LOG_FOLDER: s3://${BUCKET_NAME}/logs

AIRFLOW__CORE__LOGGING_LEVEL: INFO

AIRFLOW__CORE__LOGGING_CONFIG_CLASS: log_config.LOGGING_CONFIG

AIRFLOW__CORE__ENCRYPT_S3_LOGS: False

# End of S3 Logging

AIRFLOW__WEBSERVER__EXPOSE_CONFIG: True

AIRFLOW__WEBSERVER__LOG_FETCH_TIMEOUT_SEC: 30

AIRFLOW__KUBERNETES__WORKER_CONTAINER_REPOSITORY: airflow-docker-local

AIRFLOW__KUBERNETES__WORKER_CONTAINER_TAG: 1

AIRFLOW__KUBERNETES__WORKER_CONTAINER_IMAGE_PULL_POLICY: Never

AIRFLOW__KUBERNETES__WORKER_SERVICE_ACCOUNT_NAME: airflow

AIRFLOW__KUBERNETES__DAGS_VOLUME_CLAIM: airflow

AIRFLOW__KUBERNETES__NAMESPACE: airflow

AIRFLOW__KUBERNETES__DELETE_WORKER_PODS: True

AIRFLOW__KUBERNETES__KUBE_CLIENT_REQUEST_ARGS: '{\"_request_timeout\":[60,60]}'

persistence:

enabled: true

existingClaim: ''

accessMode: 'ReadWriteMany'

size: 5Gi

logsPersistence:

enabled: false

workers:

enabled: true

postgresql:

enabled: true

redis:

enabled: true

Я попытался настроить соединение через пользовательский интерфейс и создать соединение через airflow.yaml и, похоже, ничего не работает, я пробовал это в течение 3 дней, но безуспешно, любая помощь будет очень признательна.

Я приложил скриншот для справки,

1 ответ

Я почти уверен, что эта проблема связана с тем, что конфигурация ведения журнала s3 не была настроена для рабочих модулей. Рабочим модулям не предоставляется заданная конфигурация с использованием переменных среды, таких какAIRFLOW__CORE__REMOTE_LOGGING: True. Если вы хотите установить эту переменную в рабочем модуле, вы должны скопировать переменную и добавитьAIRFLOW__KUBERNETES_ENVIRONMENT_VARIABLES__ к имени скопированной переменной среды: AIRFLOW__KUBERNETES_ENVIRONMENT_VARIABLES__AIRFLOW__CORE__REMOTE_LOGGING: True.

В этом случае вам нужно будет продублировать все свои переменные, указав конфигурацию для ведения журнала s3, и добавить AIRFLOW__KUBERNETES_ENVIRONMENT_VARIABLES__ к копиям.