Имя выходного файла в конечную папку в pyspark

1 ответ

Решение

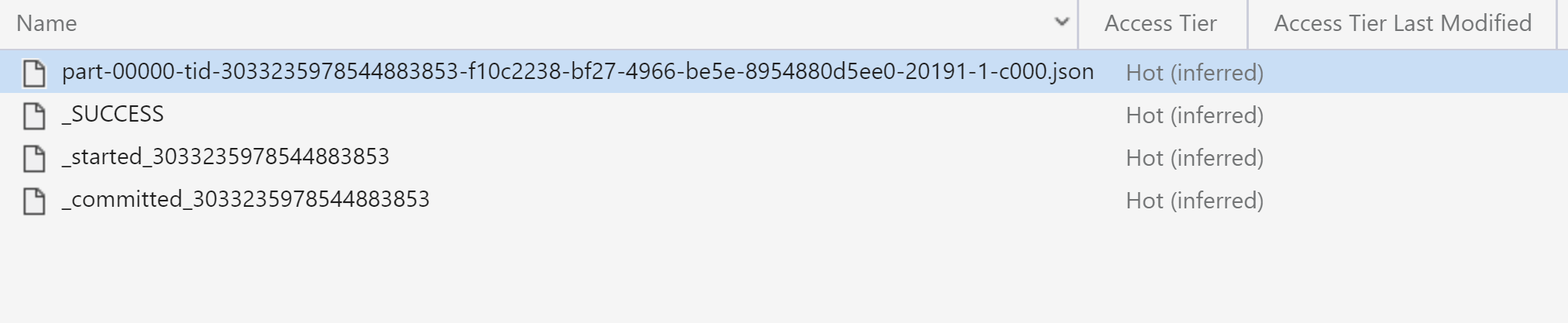

Нет, нет. Это не предполагаемый вариант использования Spark, чтобы собрать все в один раздел, а затем записать его. Для обеспечения единообразного поведения количество разделов DataFrame игнорируется при записи набора данных, папка всегда создается, причем каждый файл в этой папке связан с обрабатываемым разделом.

Однако, если вы знаете, что драйвер может содержать раздел, вы можете использовать стандартные функции Python:

import json

data = [row.asDict() for row in dataframe.collect()]

with open("name_of_file.json", "w") as fh:

json.dump(obj=data, fp=fh)

Обратите внимание, что в этом случае вы не получите формат JSONlines, но есть способы обойти это тоже.