Невозможно развернуть в кластере Kubernetes с помощью Kompose

В настоящее время я развертываю проект в кластере kubernetes, используя Kompose ( http://www.kompose.io/) для преобразования конфигурации docker-compose в файлы конфигурации kubernetes.

Это проект для мастер-класса в моем университете, и они позаботились о кластере kubernetes, поэтому я почти уверен, что конфигурация для него сделана правильно. К вашему сведению, это версия кластера Kubernetes;

$ kubectl version

Client Version: version.Info{Major:"1", Minor:"16", GitVersion:"v1.16.3", GitCommit:"b3cbbae08ec52a7fc73d334838e18d17e8512749", GitTreeState:"clean", BuildDate:"2019-11-13T11:23:11Z", GoVersion:"go1.12.12", Compiler:"gc", Platform:"linux/amd64"}

Server Version: version.Info{Major:"1", Minor:"16", GitVersion:"v1.16.3", GitCommit:"b3cbbae08ec52a7fc73d334838e18d17e8512749", GitTreeState:"clean", BuildDate:"2019-11-13T11:13:49Z", GoVersion:"go1.12.12", Compiler:"gc", Platform:"linux/amd64"}

Это версия Kompose;

$ kompose version

1.20.0 (f3d54d784)

Проблема, которая у меня есть, заключается в следующем. Я использую команду kompose convert, и это работает без каких-либо проблем, но когда я пытаюсь развернуть ее с помощью команды kompose up, возникает следующее сообщение об ошибке.

FATA Error while deploying application: Get http://localhost:8080/api: dial tcp [::1]:8080: connect: connection refused

Я впервые использую кубернеты и компосе. Я искал других, у кого также была эта проблема, но ничего не помогло в том, что я нашел.

На данный момент это мой файл для создания докеров: (я знаю, что не должен помещать пароли в файл для создания докеров, но это не часть проблемы)

version: "3"

services:

zookeeper-container:

image: confluentinc/cp-zookeeper

environment:

- ZOOKEEPER_CLIENT_PORT=2181

kafka-container:

image: confluentinc/cp-kafka

depends_on:

- zookeeper-container

environment:

- KAFKA_BROKER_ID=1

- KAFKA_ZOOKEEPER_CONNECT=zookeeper-container:2181

- KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://kafka-container:9092

- KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR=1

route-db:

image: neo4j:3.5.6

environment:

- NEO4J_AUTH=neo4j/route

ports:

- 7687:7687

delay-request-db:

image: redis

staff-db:

image: mongo

train-db:

image: mongo

maintenance-db:

image: mysql:5.7

command: --default-authentication-plugin=mysql_native_password

environment:

- MYSQL_ROOT_PASSWORD=maintenancedatabase

- MYSQL_DATABASE=Maintenance

station-db:

image: mysql:5.7

command: --default-authentication-plugin=mysql_native_password

environment:

- MYSQL_ROOT_PASSWORD=stationdatabase

- MYSQL_DATABASE=Station

ticket-sale-db:

image: mysql:5.7

command: --default-authentication-plugin=mysql_native_password

environment:

- MYSQL_ROOT_PASSWORD=ticketsaledatabase

- MYSQL_DATABASE=TicketSale

ticket-validation-db:

image: mysql:5.7

command: --default-authentication-plugin=mysql_native_password

environment:

- MYSQL_ROOT_PASSWORD=ticketvalidationdatabase

- MYSQL_DATABASE=TicketValidation

timetable-db:

image: mysql:5.7

command: --default-authentication-plugin=mysql_native_password

environment:

- MYSQL_ROOT_PASSWORD=timetabledatabase

- MYSQL_DATABASE=Timetable

delay-service:

build: ./railway-app-delay

image: gilliswerrebrouck/railway-app-delay-service

volumes:

- ./railway-app-delay/target:/app

links:

- kafka-container

- zookeeper-container

depends_on:

- kafka-container

- zookeeper-container

maintenance-service:

build: ./railway-app-maintenance

image: gilliswerrebrouck/railway-app-maintenance-service

volumes:

- ./railway-app-maintenance/target:/app

links:

- kafka-container

- zookeeper-container

- maintenance-db

depends_on:

- kafka-container

- zookeeper-container

- maintenance-db

route-service:

build: ./railway-app-route-management

image: gilliswerrebrouck/railway-app-route-management-service

volumes:

- ./railway-app-route-management/target:/app

links:

- kafka-container

- zookeeper-container

- route-db

depends_on:

- kafka-container

- zookeeper-container

- route-db

staff-service:

build: ./railway-app-staff

image: gilliswerrebrouck/railway-app-staff-service

volumes:

- ./railway-app-staff/target:/app

links:

- kafka-container

- zookeeper-container

- staff-db

depends_on:

- kafka-container

- zookeeper-container

- staff-db

station-service:

build: ./railway-app-station

image: gilliswerrebrouck/railway-app-station-service

volumes:

- ./railway-app-station/target:/app

links:

- kafka-container

- zookeeper-container

- station-db

- delay-request-db

depends_on:

- kafka-container

- zookeeper-container

- station-db

- delay-request-db

ticket-sale-service:

build: ./railway-app-ticket-sale

image: gilliswerrebrouck/railway-app-ticket-sale-service

volumes:

- ./railway-app-ticket-sale/target:/app

links:

- kafka-container

- zookeeper-container

- ticket-sale-db

depends_on:

- kafka-container

- zookeeper-container

- ticket-sale-db

ticket-validation-service:

build: ./railway-app-ticket-validation

image: gilliswerrebrouck/railway-app-ticket-validation-service

volumes:

- ./railway-app-ticket-validation/target:/app

links:

- kafka-container

- zookeeper-container

- ticket-validation-db

depends_on:

- kafka-container

- zookeeper-container

- ticket-validation-db

timetable-service:

build: ./railway-app-timetable

image: gilliswerrebrouck/railway-app-timetable-service

volumes:

- ./railway-app-timetable/target:/app

links:

- kafka-container

- zookeeper-container

- timetable-db

- route-service

- station-service

- train-service

depends_on:

- kafka-container

- zookeeper-container

- timetable-db

- route-service

- station-service

- train-service

train-service:

build: ./railway-app-train

image: gilliswerrebrouck/railway-app-train-service

volumes:

- ./railway-app-train/target:/app

links:

- kafka-container

- zookeeper-container

- train-db

depends_on:

- kafka-container

- zookeeper-container

- train-db

apigateway:

build: ./railway-app-api-gateway

image: gilliswerrebrouck/railway-app-api-gateway-service

volumes:

- ./railway-app-api-gateway/target:/app

links:

- kafka-container

- zookeeper-container

- delay-service

- maintenance-service

- route-service

- staff-service

- station-service

- ticket-sale-service

- ticket-validation-service

- timetable-service

- train-service

depends_on:

- kafka-container

- zookeeper-container

- delay-service

- maintenance-service

- route-service

- staff-service

- station-service

- ticket-sale-service

- ticket-validation-service

- timetable-service

- train-service

ports:

- 8080:8080

frontend:

build: ./railway-app-frontend

image: gilliswerrebrouck/railway-app-frontend

volumes:

- ./railway-app-frontend/target:/app

links:

- apigateway

- route-db

depends_on:

- apigateway

- route-db

ports:

- 80:80

У кого-нибудь есть советы о том, как устранить эту проблему или как ее исправить?

ОБНОВИТЬ:

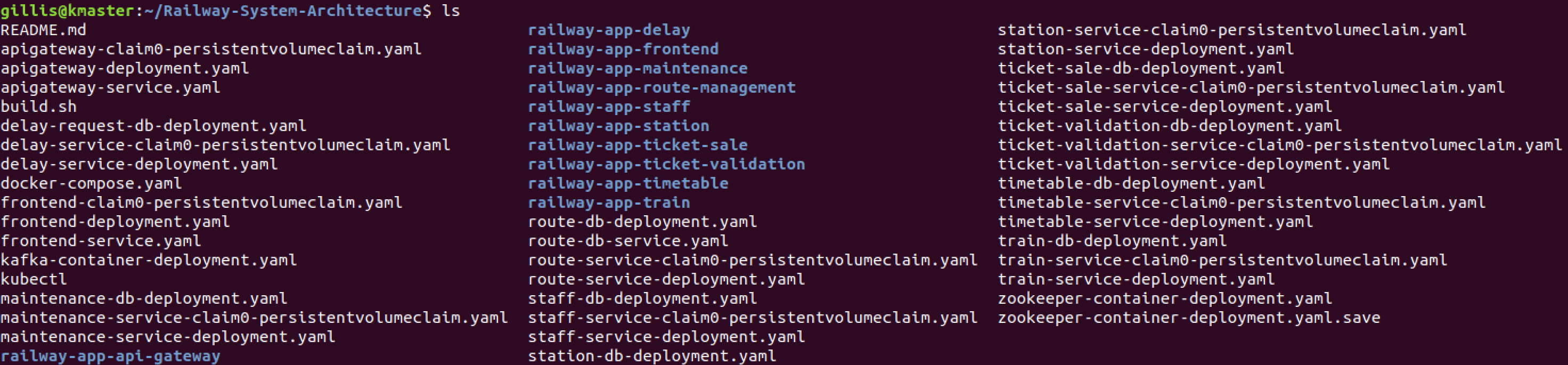

Это файлы, созданные kompose convert команда

1 ответ

Я решил это, заменив все apiversion в файлах развертывания с v1beta2 на apps / v1 и добавив селектор к каждому развертыванию.

selector:

matchLabels:

app: ...

Тогда я не использовал команду Kompose up для развертывания, поскольку это дает мне ошибку, но я использовал команду kubectl create -f <file(s)>для развертывания, и это удалось без ошибки подключения. Некоторые модули все еще выходят из строя, но я не думаю, что это имеет какое-либо отношение к исходной проблеме.