Продолжайте работать в режиме "Превышен крайний срок выполнения", несмотря на изменение progressDeadlineSeconds

Я новичок в конвейерах AKS, ACR и DevOps, и я пытаюсь настроить конвейер CI/CD.

У меня есть настройка группы ресурсов, в которой есть как AKS, так и ACR. AKS используетStandard_B2s и только один узел на данный момент, так как я просто играю.

Образы развертываются в ACR автоматически при фиксации в мастере - еще не понял, как настроить тестирование - но когда дело доходит до развертывания в AKS, я просто продолжаю получать:

##[error]error: deployment "client-deployment" exceeded its progress deadline

Я изменил свой client.yaml включить progressDeadlineSeconds вроде часа, поскольку 10, 15 и 20 минут не работали:

apiVersion: apps/v1

kind: Deployment

metadata:

name: client-deployment

spec:

progressDeadlineSeconds: 3600

replicas: 1

selector:

matchLabels:

component: client

template:

metadata:

labels:

component: client

spec:

containers:

- name: client

image: testappcontainers.azurecr.io/testapp-client

ports:

- containerPort: 3000

---

apiVersion: v1

kind: Service

metadata:

name: client-cluster-ip-service

spec:

type: ClusterIP

selector:

component: client

ports:

- port: 3000

targetPort: 3000

Я только что модифицировал azure-pipelines.yml эти конвейеры, созданные для меня, которые сейчас у меня следующие:

# Docker

# Build and push an image to Azure Container Registry

# https://docs.microsoft.com/azure/devops/pipelines/languages/docker

trigger:

- master

resources:

- repo: self

variables:

# Container registry service connection established during pipeline creation

dockerRegistryServiceConnection: <dockerRegistryServiceConnection_key>

imageRepository: 'testapp'

containerRegistry: 'testappcontainers.azurecr.io'

dockerfilePath: '$(Build.SourcesDirectory)'

tag: '$(Build.BuildId)'

imagePullSecret: <imagePullSecret_key>

# Agent VM image name

vmImageName: 'ubuntu-latest'

stages:

- stage: Build

displayName: Build and push stage

jobs:

- job: Build

displayName: Build

pool:

vmImage: $(vmImageName)

steps:

- task: Docker@2

displayName: Build and push client image to container registry

inputs:

command: buildAndPush

repository: $(imageRepository)-client

dockerfile: $(dockerfilePath)/client/Dockerfile

containerRegistry: $(dockerRegistryServiceConnection)

tags: |

$(tag)

- upload: manifests

artifact: manifests

- stage: Deploy

displayName: Deploy stage

dependsOn: Build

jobs:

- deployment: Deploy

displayName: Deploy job

pool:

vmImage: $(vmImageName)

environment: 'testapp.default'

strategy:

runOnce:

deploy:

steps:

- task: KubernetesManifest@0

displayName: Create imagePullSecret

inputs:

action: createSecret

secretName: $(imagePullSecret)

dockerRegistryEndpoint: $(dockerRegistryServiceConnection)

- task: KubernetesManifest@0

displayName: Deploy to Kubernetes cluster

inputs:

action: deploy

manifests: |

$(Pipeline.Workspace)/manifests/client.yaml

imagePullSecrets: |

$(imagePullSecret)

containers: |

$(containerRegistry)/$(imageRepository):$(tag)

Вот и журнал сбойной задачи:

##[debug]Evaluating condition for step: 'Deploy to Kubernetes cluster'

##[debug]Evaluating: SucceededNode()

##[debug]Evaluating SucceededNode:

##[debug]=> True

##[debug]Result: True

##[section]Starting: Deploy to Kubernetes cluster

==============================================================================

Task : Deploy to Kubernetes

Description : Use Kubernetes manifest files to deploy to clusters or even bake the manifest files to be used for deployments using Helm charts

Version : 0.162.1

Author : Microsoft Corporation

Help : https://docs.microsoft.com/en-us/azure/devops/pipelines/tasks/deploy/kubernetes-manifest

==============================================================================

##[debug]agent.TempDirectory=/home/vsts/work/_temp

##[debug]loading inputs and endpoints

##[debug]loading INPUT_ACTION

##[debug]loading INPUT_KUBERNETESSERVICECONNECTION

##[debug]loading INPUT_STRATEGY

##[debug]loading INPUT_TRAFFICSPLITMETHOD

##[debug]loading INPUT_PERCENTAGE

##[debug]loading INPUT_BASELINEANDCANARYREPLICAS

##[debug]loading INPUT_MANIFESTS

##[debug]loading INPUT_CONTAINERS

##[debug]loading INPUT_IMAGEPULLSECRETS

##[debug]loading INPUT_RENDERTYPE

##[debug]loading INPUT_DOCKERCOMPOSEFILE

##[debug]loading INPUT_HELMCHART

##[debug]loading INPUT_KUSTOMIZATIONPATH

##[debug]loading INPUT_RESOURCETOPATCH

##[debug]loading INPUT_RESOURCEFILETOPATCH

##[debug]loading INPUT_MERGESTRATEGY

##[debug]loading INPUT_SECRETTYPE

##[debug]loading ENDPOINT_AUTH_<token>

##[debug]loading ENDPOINT_AUTH_SCHEME_<token>

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_AZUREENVIRONMENT

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_AZURETENANTID

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_SERVICEACCOUNTNAME

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_ROLEBINDINGNAME

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_SECRETNAME

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_APITOKEN

##[debug]loading ENDPOINT_AUTH_PARAMETER_<token>_SERVICEACCOUNTCERTIFICATE

##[debug]loading ENDPOINT_AUTH_SYSTEMVSSCONNECTION

##[debug]loading ENDPOINT_AUTH_SCHEME_SYSTEMVSSCONNECTION

##[debug]loading ENDPOINT_AUTH_PARAMETER_SYSTEMVSSCONNECTION_ACCESSTOKEN

##[debug]loading SECRET_CONTAINER_PASSWORD

##[debug]loading SECRET_CONTAINER_USERNAME

##[debug]loading SECRET_SYSTEM_ACCESSTOKEN

##[debug]loaded 32

##[debug]Agent.ProxyUrl=undefined

##[debug]Agent.CAInfo=undefined

##[debug]Agent.ClientCert=undefined

##[debug]Agent.SkipCertValidation=undefined

##[debug]SYSTEM_HOSTTYPE=build

##[debug]System.TeamFoundationCollectionUri=https://dev.azure.com/thetestcompany/

##[debug]Build.BuildNumber=20191231.5

##[debug]Build.DefinitionName=test-app

##[debug]System.DefinitionId=4

##[debug]Agent.JobName=Deploy job

##[debug]System.TeamProject=test-app

##[debug]Build.BuildId=41

##[debug]System.TeamProject=test-app

##[debug]namespace=null

##[debug]containers=***/testapp:41

##[debug]imagePullSecrets=testappcontainers<key>-auth

##[debug]manifests=/home/vsts/work/1/manifests/client.yaml

##[debug]percentage=0

##[debug]strategy=none

##[debug]trafficSplitMethod=pod

##[debug]baselineAndCanaryReplicas=0

##[debug]arguments=null

##[debug]secretArguments=null

##[debug]secretType=dockerRegistry

##[debug]secretName=null

##[debug]dockerRegistryEndpoint=null

##[debug]kubernetesServiceConnection=<token>

##[debug]<token> data namespace = default

##[debug]System.TeamFoundationCollectionUri=https://dev.azure.com/thetestcompany/

##[debug]System.HostType=build

##[debug]System.DefaultWorkingDirectory=/home/vsts/work/1/s

##[debug]Build.SourceBranchName=master

##[debug]Build.Repository.Provider=TfsGit

##[debug]Build.Repository.Uri=https://thetestcompany@dev.azure.com/thetestcompany/test-app/_git/test-app

##[debug]agent.proxyurl=undefined

##[debug]VSTS_ARM_REST_IGNORE_SSL_ERRORS=undefined

##[debug]AZURE_HTTP_USER_AGENT=VSTS_<hash>_build_4_0

##[debug]Agent.ProxyUrl=undefined

##[debug]Agent.CAInfo=undefined

##[debug]Agent.ClientCert=undefined

##[debug]check path : /home/vsts/work/_tasks/KubernetesManifest_<hash>/0.162.1/node_modules/azure-pipelines-tool-lib/lib.json

##[debug]adding resource file: /home/vsts/work/_tasks/KubernetesManifest_<hash>/0.162.1/node_modules/azure-pipelines-tool-lib/lib.json

##[debug]system.culture=en-US

##[debug]check path : /home/vsts/work/_tasks/KubernetesManifest_<hash>/0.162.1/task.json

##[debug]adding resource file: /home/vsts/work/_tasks/KubernetesManifest_<hash>/0.162.1/task.json

##[debug]system.culture=en-US

##[debug]action=deploy

##[debug]kubernetesServiceConnection=<token>

##[debug]agent.tempDirectory=/home/vsts/work/_temp

##[debug]<token> data authorizationType = AzureSubscription

##[debug]<token>=https://testappk8s-dns-<key>.hcp.westus.azmk8s.io/

##[debug]<token> auth param serviceAccountCertificate = ***

##[debug]<token> auth param apiToken = ***

##[debug]set KUBECONFIG=/home/vsts/work/_temp/kubectlTask/1577816701759/config

##[debug]Processed: ##vso[task.setvariable variable=KUBECONFIG;issecret=false;]/home/vsts/work/_temp/kubectlTask/1577816701759/config

##[debug]<token> data acceptUntrustedCerts = undefined

##[debug]which 'kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]which 'kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]System.DefaultWorkingDirectory=/home/vsts/work/1/s

##[debug]defaultRoot: '/home/vsts/work/1/s'

##[debug]findOptions.allowBrokenSymbolicLinks: 'false'

##[debug]findOptions.followSpecifiedSymbolicLink: 'true'

##[debug]findOptions.followSymbolicLinks: 'true'

##[debug]matchOptions.debug: 'false'

##[debug]matchOptions.nobrace: 'true'

##[debug]matchOptions.noglobstar: 'false'

##[debug]matchOptions.dot: 'true'

##[debug]matchOptions.noext: 'false'

##[debug]matchOptions.nocase: 'false'

##[debug]matchOptions.nonull: 'false'

##[debug]matchOptions.matchBase: 'false'

##[debug]matchOptions.nocomment: 'false'

##[debug]matchOptions.nonegate: 'false'

##[debug]matchOptions.flipNegate: 'false'

##[debug]pattern: '/home/vsts/work/1/manifests/client.yaml'

##[debug]findPath: '/home/vsts/work/1/manifests/client.yaml'

##[debug]statOnly: 'true'

##[debug]found 1 paths

##[debug]applying include pattern

##[debug]1 matches

##[debug]1 final results

##[debug]agent.tempDirectory=/home/vsts/work/_temp

##[debug]New K8s objects after addin imagePullSecrets are :[{"apiVersion":"apps/v1","kind":"Deployment","metadata":{"name":"client-deployment"},"spec":{"progressDeadlineSeconds":3600,"replicas":1,"selector":{"matchLabels":{"component":"client"}},"template":{"metadata":{"labels":{"component":"client"}},"spec":{"containers":[{"name":"client","image":"***/testapp-client","ports":[{"containerPort":3000}]}],"imagePullSecrets":[{"name":"testappcontainers1741032e-auth"}]}}}},{"apiVersion":"v1","kind":"Service","metadata":{"name":"client-cluster-ip-service"},"spec":{"type":"ClusterIP","selector":{"component":"client"},"ports":[{"port":3000,"targetPort":3000}]}}]

##[debug]agent.tempDirectory=/home/vsts/work/_temp

##[debug]agent.tempDirectory=/home/vsts/work/_temp

##[debug]which '/usr/bin/kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]which '/usr/bin/kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]/usr/bin/kubectl arg: apply

##[debug]/usr/bin/kubectl arg: ["-f","/home/vsts/work/_temp/Deployment_client-deployment_1577816701782,/home/vsts/work/_temp/Service_client-cluster-ip-service_1577816701782"]

##[debug]/usr/bin/kubectl arg: ["--namespace","default"]

##[debug]exec tool: /usr/bin/kubectl

##[debug]arguments:

##[debug] apply

##[debug] -f

##[debug] /home/vsts/work/_temp/Deployment_client-deployment_1577816701782,/home/vsts/work/_temp/Service_client-cluster-ip-service_1577816701782

##[debug] --namespace

##[debug] default

[command]/usr/bin/kubectl apply -f /home/vsts/work/_temp/Deployment_client-deployment_1577816701782,/home/vsts/work/_temp/Service_client-cluster-ip-service_1577816701782 --namespace default

deployment.apps/client-deployment unchanged

service/client-cluster-ip-service unchanged

##[debug]which '/usr/bin/kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]which '/usr/bin/kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]/usr/bin/kubectl arg: ["rollout","status"]

##[debug]/usr/bin/kubectl arg: Deployment/client-deployment

##[debug]/usr/bin/kubectl arg: ["--namespace","default"]

##[debug]exec tool: /usr/bin/kubectl

##[debug]arguments:

##[debug] rollout

##[debug] status

##[debug] Deployment/client-deployment

##[debug] --namespace

##[debug] default

[command]/usr/bin/kubectl rollout status Deployment/client-deployment --namespace default

error: deployment "client-deployment" exceeded its progress deadline

##[debug]which '/usr/bin/kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]which '/usr/bin/kubectl'

##[debug]found: '/usr/bin/kubectl'

##[debug]/usr/bin/kubectl arg: get

##[debug]/usr/bin/kubectl arg: service/client-cluster-ip-service

##[debug]/usr/bin/kubectl arg: ["-o","json"]

##[debug]/usr/bin/kubectl arg: ["--namespace","default"]

##[debug]exec tool: /usr/bin/kubectl

##[debug]arguments:

##[debug] get

##[debug] service/client-cluster-ip-service

##[debug] -o

##[debug] json

##[debug] --namespace

##[debug] default

[command]/usr/bin/kubectl get service/client-cluster-ip-service -o json --namespace default

{

"apiVersion": "v1",

"kind": "Service",

"metadata": {

"annotations": {

"kubectl.kubernetes.io/last-applied-configuration": "{\"apiVersion\":\"v1\",\"kind\":\"Service\",\"metadata\":{\"annotations\":{},\"name\":\"client-cluster-ip-service\",\"namespace\":\"default\"},\"spec\":{\"ports\":[{\"port\":3000,\"targetPort\":3000}],\"selector\":{\"component\":\"client\"},\"type\":\"ClusterIP\"}}\n"

},

"creationTimestamp": "name": "client-cluster-ip-service",

"namespace": "default",

"resourceVersion": "1234045",

"selfLink": "/api/v1/namespaces/default/services/client-cluster-ip-service",

"uid": "5f077159-2bdd-11ea-af20-3eaa105eb2b3"

},

"spec": {

"clusterIP": "10.0.181.220",

"ports": [

{

"port": 3000,

"protocol": "TCP",

"targetPort": 3000

}

],

"selector": {

"component": "client"

},

"sessionAffinity": "None",

"type": "ClusterIP"

},

"status": {

"loadBalancer": {}

}

}

##[debug]KUBECONFIG=/home/vsts/work/_temp/kubectlTask/1577816701759/config

##[debug]set KUBECONFIG=

##[debug]Processed: ##vso[task.setvariable variable=KUBECONFIG;issecret=false;]

##[debug]task result: Failed

##[error]error: deployment "client-deployment" exceeded its progress deadline

##[debug]Processed: ##vso[task.issue type=error;]error: deployment "client-deployment" exceeded its progress deadline

##[debug]Processed: ##vso[task.complete result=Failed;]error: deployment "client-deployment" exceeded its progress deadline

##[section]Finishing: Deploy to Kubernetes cluster

Затем в Azure CLI он показывает, что развертывание есть, но нет доступных модулей:

eox-dev@Azure:~$ kubectl get deployments

NAME READY UP-TO-DATE AVAILABLE AGE

client-deployment 0/1 1 0 3h47m

eox-dev@Azure:~$ kubectl describe deployment client-deployment

Name: client-deployment

Namespace: default

CreationTimestamp: Tue, 31 Dec 2019 15:50:30 +0000

Labels: <none>

Annotations: deployment.kubernetes.io/revision: 1

kubectl.kubernetes.io/last-applied-configuration:

{"apiVersion":"apps/v1","kind":"Deployment","metadata":{"annotations":{},"name":"client-deployment","namespace":"default"},"spec":{"progre...

Selector: component=client

Replicas: 1 desired | 1 updated | 1 total | 0 available | 1 unavailable

StrategyType: RollingUpdate

MinReadySeconds: 0

RollingUpdateStrategy: 25% max unavailable, 25% max surge

Pod Template:

Labels: component=client

Containers:

client:

Image: testappcontainers.azurecr.io/testapp-client

Port: 3000/TCP

Host Port: 0/TCP

Environment: <none>

Mounts: <none>

Volumes: <none>

Conditions:

Type Status Reason

---- ------ ------

Available False MinimumReplicasUnavailable

Progressing False ProgressDeadlineExceeded

OldReplicaSets: <none>

NewReplicaSet: client-deployment-5688bdc69c (1/1 replicas created)

Events: <none>

Так что я здесь делаю не так?

8 ответов

Ошибка сервера (BadRequest): контейнер "клиент" в модуле "client-deployment-5688bdc69c-hxlcf" ожидает запуска: попытка получения образа, но не удается

Исходя из моего опыта, это более относительно с imagePullSecrets и Kubernetes namespace.

В вашем Create imagePullSecret а также Deploy to Kubernetes cluster task, я видел, что вы не указали значение параметра задачи: namespace. Это приведет к новому пространству имен с именемdefault будет создан, поскольку вы не указали пространство имен.

И секрет кубернетов, созданныйcreateSecretдействие отделено для каждого пространства имен. Одним словом, разные пространства имен имеют разное секретное значение:

Секреты хранятся в заданном пространстве имен и могут быть доступны только модулям в том же пространстве имен.

Теперь вернемся к процессу компиляции сборки.

В вашем определении yml Create imagePullSecret создаст secret для нового пространства имен default который создается задачей автоматически, поскольку вы не предоставили заданное значение пространства имен.

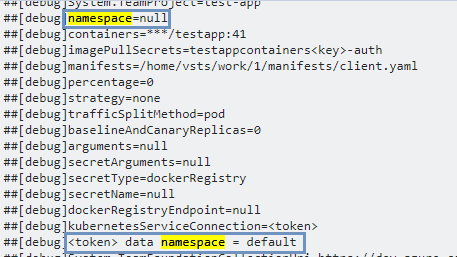

Затем в следующей задаче Deploy to Kubernetes cluster, по той же причине здесь задача воссоздает другое новое пространство имен default(Примечание: это не то же самое, что и предыдущее). Также вы могли видеть этот прогресс в журнале:

В это время secretсозданный из предыдущей задачи, будет недоступен для текущего пространства имен. НО, как известно,ACR - это частный реестр контейнеров, который наша система должна проверять, kubernetes secret доступен.

Кроме того, в задаче "Развертывание в кластере Kubernetes" вы указали репозиторий как $(imageRepository) что не то же самое с репозиторием, в который вы отправляете изображение $(imageRepository)-client.

Это также можно проверить в своем журнале:

Вот почему в ваших кубернетах нет доступного узла, и вы также не смогли вытащить образ.

Во избежание проблемы убедитесь, что вы предоставили namespace ценность в KubernetesManifest@0 задача.

- task: KubernetesManifest@0

displayName: Create imagePullSecret

inputs:

action: createSecret

secretName: $(imagePullSecret)

namespace: $(k8sNamespace)

dockerRegistryEndpoint: $(DRServiceConnection)

- task: KubernetesManifest@0

displayName: Deploy to Kubernetes cluster

inputs:

action: deploy

namespace: $(k8sNamespace)

manifests: |

$(System.ArtifactsDirectory)/manifests/deployment.yml

imagePullSecrets: |

$(imagePullSecret)

containers: |

$(containerRegistry)/$(imageRepository)-client:$(tag)

секрет для imagePullSecrets каждого пространства имен

Я столкнулся с аналогичными проблемами, даже при условии, что пространство имен все еще получало ошибку "Превышен крайний срок выполнения. Ожидание завершения развертывания"XX-service": доступно 0 из 1 обновленных реплик..."

из-за того, что не удалось извлечь изображение

Добавление imagePullPolicy: Always в.yaml устранило мои проблемы с извлечением развертывания.

Я думаю, что эта проблема может возникнуть (особенно в AKS), если ваш кластер выполняет проверку работоспособности или живучести ваших контейнеров перед развертыванием. Ваш кластер определяет, что ваше приложение не запущено, и переходит в состояние ожидания из-за CrashLoopBackOff.

Это можно исправить, просто создав маршрут GET по умолчанию в вашем приложении API на «/», который возвращает 200. Это будет указывать на то, что ваши контейнеры исправны или работают.

бросаю сюда свои 2 цента за то, что случилось с нашим:

Как оказалось, эта ошибка может отображаться практически по любой причине, которая может помешать запуску кластера k8s и/или получению данного образа.

Наша проблема была не с нашим контейнером, а с его получением из реестра контейнеров.

Просто запустите в кластере следующее, чтобы увидеть проблему с ImagePullBackoff, а затем запустите другую команду, чтобы получить дополнительную информацию:

kubectl get all --namespace=the-namespace-its-in # get all resources e.g. deployments, pods, etc

kubectl describe pods/my-imagepullbackoff-pod # Look at the events section at the bottom for more info!

После этого мы смогли подтвердить, что возникла проблема с извлечением данных из Реестра контейнеров Azure. Чтобы предотвратить это в будущем, мы используем такие функции реестра контейнеров, как и Zone RedundancyGeoreplication .

Тоже столкнулся с такой ошибкой, но в моем случае превышение квоты:

Error creating: pods "my-service-dev-5898568fd8-jnx77" is forbidden: exceeded quota: compute-resources, requested: cpu=400m, used: cpu=6750m, limited: cpu=7

Я столкнулся с этой ошибкой, но в моем случае я не включил в файл требований некоторые необходимые модули для правильного развертывания. Для Джанго запуститеpipreqs

В моем случае это была проблема с рабочим узлом. Поэтому я просто попытался вытащить изображение с узла, которому назначен мой модуль. Я узнал, что у узла есть некоторые проблемы, связанные с производительностью, поэтому я просто добавляю новый узел с высокими характеристиками и назначаю модуль этому узлу. Развертывание также прошло успешно.

Я столкнулся с аналогичной проблемой из-за исключения, а также сбоев проверки готовности. После решения этих проблем развертывание было успешно завершено.