Не удалось преобразовать замороженный граф тензорного потока в файл pbtxt

Я хочу извлечь файл pbtxt с учетом ввода замороженного графа вывода тензорного потока. Для этого я использую следующий скрипт:

import tensorflow as tf

#from google.protobuf import text_format

from tensorflow.python.platform import gfile

def converter(filename):

with gfile.FastGFile(filename,'rb') as f:

graph_def = tf.GraphDef()

graph_def.ParseFromString(f.read())

tf.import_graph_def(graph_def, name='')

tf.train.write_graph(graph_def, 'pbtxt/', 'protobuf.pbtxt', as_text=True)

print(graph_def)

return

#converter('ssd_mobilenet_v1_coco_2017_11_17/frozen_inference_graph.pb') # here you can write the name of the file to be converted

# and then a new file will be made in pbtxt directory.

converter('ssd_mobilenet_v1_coco_2017_11_17/frozen_inference_graph.pb')

В качестве примера я использую архитектуру ssd mobilenet. Используя приведенный выше код, я получаю вывод в виде pbtxt, но не могу его использовать. Для справки смотрите изображение ниже

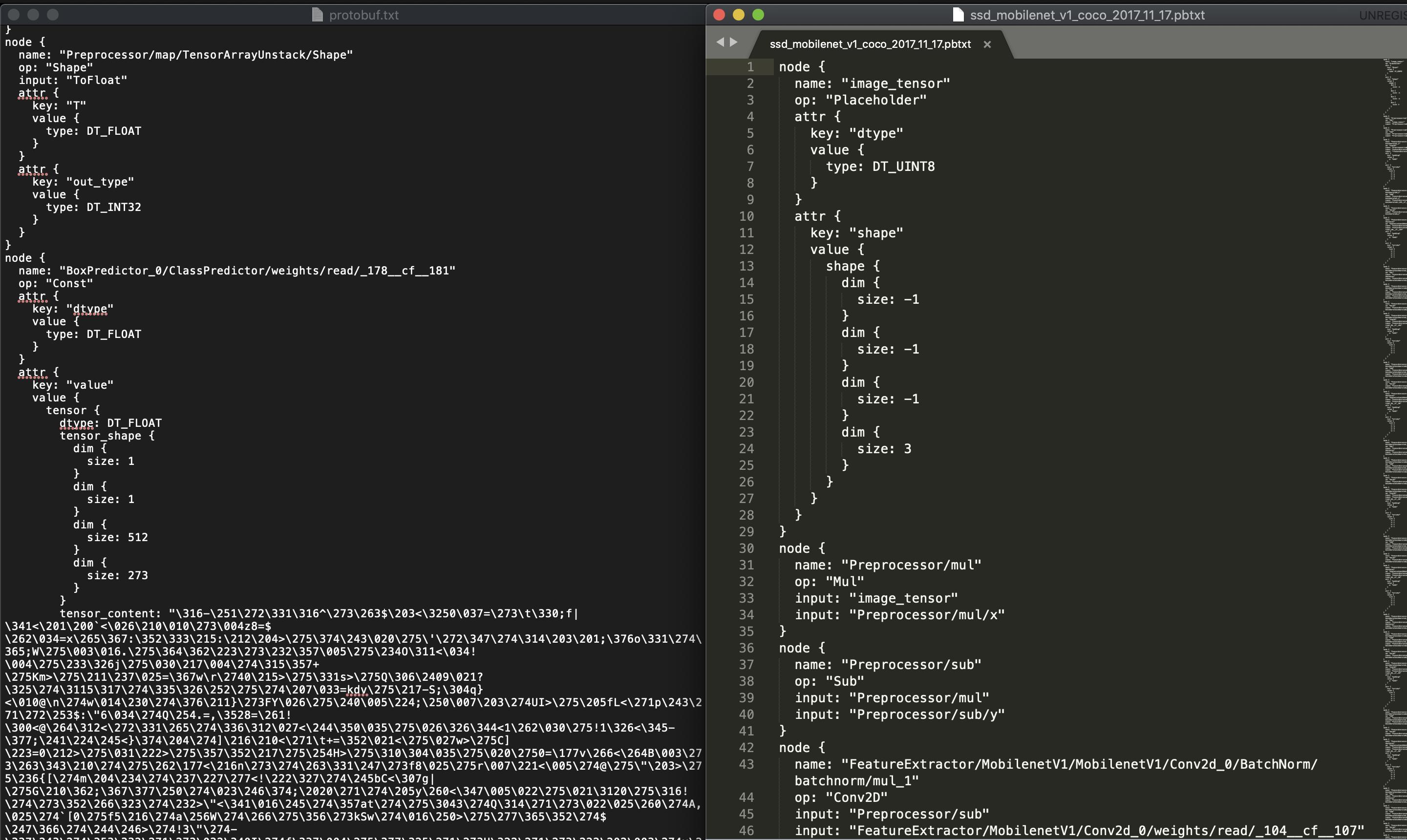

ВПРАВО: Изображение исходного файла pbtxt для архитектуры мобильной сети

LEFT: изображение файла pbtxt, полученное с помощью вышеуказанного скрипта.

Когда я использую официальный pbtxt на право, я получаю правильные результаты. Но я не получаю никакого прогноза, когда использую LEFT pbtxt, который я сгенерировал с помощью приведенного выше скрипта

Я использую эти прогнозы на открытом модуле CV DNN

tensorflowNet = cv2.dnn.readNetFromTensorflow('ssd_mobilenet_v1_coco_2017_11_17/frozen_inference_graph.pb', 'pbtxt/protobuf.pbtxt')

Как мне преобразовать замороженный вывод логики mobilenet в правильный формат pbtxt, чтобы получить вывод?

Ссылки: https://gist.github.com/Arafatk/c063bddb9b8d17a037695d748db4f592

4 ответа

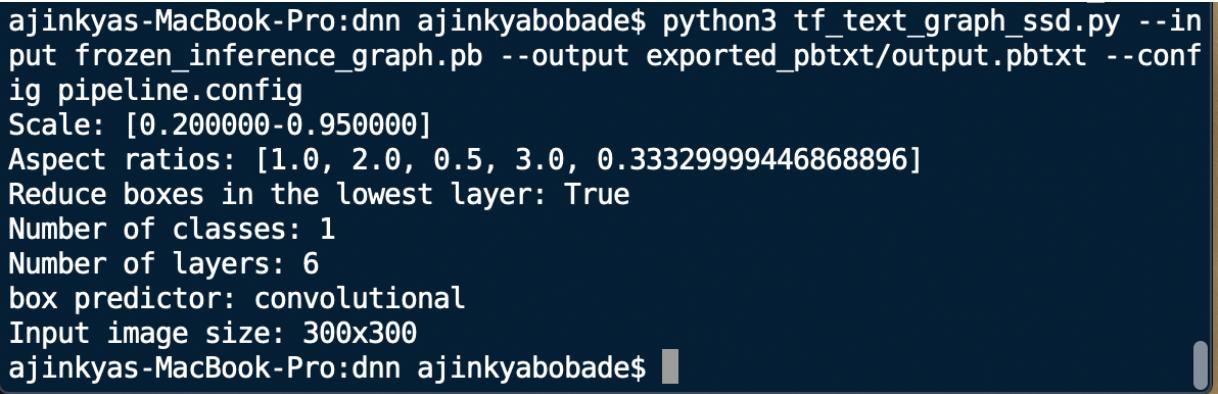

Вот что сработало для меня

- git clone https://github.com/opencv/opencv.git

- Перейдите к opencv / samples / dnn /

- Скопируйте файл frozen_inference_graph.pb и *.config, соответствующий вашему pb-файлу.

- Вставьте скопированные файлы в каталог opencv / samples / dnn

- Создайте новую папку в каталоге den и назовите ее "exported_pbtxt"

И запустите этот скрипт:

python3 tf_text_graph_ssd.py --input frozen_inference_graph.pb --output exported_pbtxt/output.pbtxt --config pipeline.config

Это все, что вам нужно, теперь скопируйте замороженный граф вывода и недавно сгенерированный файл pbtxt. И используйте следующий скрипт для запуска вашей модели с использованием OpenCV:

import cv2

# Load a model imported from Tensorflow

tensorflowNet = cv2.dnn.readNetFromTensorflow('card_graph/frozen_inference_graph.pb', 'exported_pbtxt/output.pbtxt')

# Input image

img = cv2.imread('image.jpg')

rows, cols, channels = img.shape

# Use the given image as input, which needs to be blob(s).

tensorflowNet.setInput(cv2.dnn.blobFromImage(img, size=(300, 300), swapRB=True, crop=False))

# Runs a forward pass to compute the net output

networkOutput = tensorflowNet.forward()

# Loop on the outputs

for detection in networkOutput[0,0]:

score = float(detection[2])

if score > 0.9:

left = detection[3] * cols

top = detection[4] * rows

right = detection[5] * cols

bottom = detection[6] * rows

#draw a red rectangle around detected objects

cv2.rectangle(img, (int(left), int(top)), (int(right), int(bottom)), (0, 0, 255), thickness=2)

# Show the image with a rectagle surrounding the detected objects

cv2.imshow('Image', img)

cv2.waitKey()

cv2.destroyAllWindows()

Пожалуйста, следуйте этому руководству: https://github.com/opencv/opencv/wiki/TensorFlow-Object-Detection-API. Нет смысла создавать.pbtxt без его изменения. Сценарий из руководства создает дополнительный текстовый график, который используется для импорта в OpenCV.

Может кому-нибудь помочь. Встретил ту же проблему с mars-small128.pb для OpenCV 4.3.0, извлеченный из мастера

import argparse

import tensorflow as tf

from tensorflow.python.saved_model import signature_constants

def save(graph_pb, export_dir):

builder = tf.saved_model.builder.SavedModelBuilder(export_dir)

with tf.gfile.GFile(graph_pb, "rb") as f:

graph_def = tf.GraphDef()

graph_def.ParseFromString(f.read())

sigs = {}

with tf.Session(graph=tf.Graph()) as sess:

# INFO: name="" is important to ensure we don't get spurious prefixing

tf.import_graph_def(graph_def, name='')

g = tf.get_default_graph()

# INFO: if name is added the input/output should be prefixed like:

# name=net => net/images:0 & net/features:0

inp = tf.get_default_graph().get_tensor_by_name("images:0")

out = tf.get_default_graph().get_tensor_by_name("features:0")

sigs[signature_constants.DEFAULT_SERVING_SIGNATURE_DEF_KEY] = \

tf.saved_model.signature_def_utils.predict_signature_def(

{"in": inp}, {"out": out})

builder.add_meta_graph_and_variables(sess,

[tag_constants.SERVING],

signature_def_map=sigs)

builder.save(as_text=True)

if __name__ == '__main__':

# export_dir = './saved'

# graph_pb = '../models/deep_sort/mars-small128.pb'

parser = argparse.ArgumentParser()

parser.add_argument('--input', help="path to frozen pb file")

parser.add_argument('--output', help="Folder to save")

args = parser.parse_args()

if args.input is not None and args.output:

save(args.input, args.output)

else:

print(f"Usage adapt_opencv.py.py --input 'path_to_bp' --output './saved'")

Преобразование pb в pbtxt для TF 2.xxx:

import tensorflow as tf

from google.protobuf import text_format

from tensorflow.python.platform import gfile

def graphdef_to_pbtxt(filename):

with open(filename,'rb') as f:

graph_def = tf.compat.v1.GraphDef()

graph_def.ParseFromString(f.read())

with open('protobuf.txt', 'w') as fp:

fp.write(str(graph_def))

graphdef_to_pbtxt('saved_model.pb')