seq2seq всегда дает один и тот же прогноз

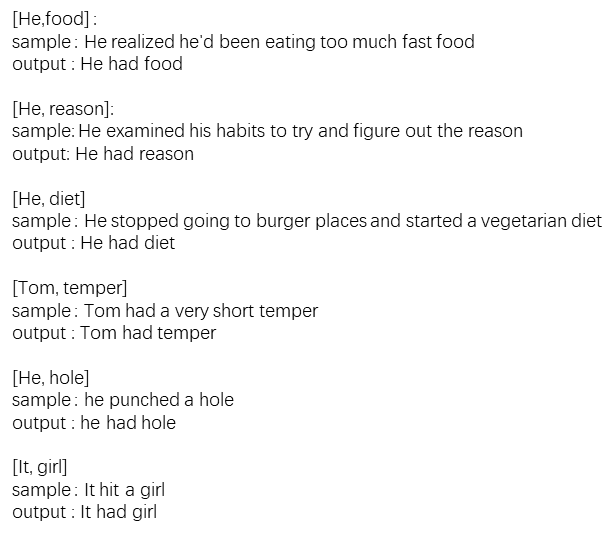

Я тренирую сеть seq2seq, чтобы принимать слова субъекта и объекта в качестве входных данных и пытаться предсказать глагол. Я проверил, предоставив тот же предмет и объект, что и данные обучения, и проверил, может ли прогноз повторить образец обучения. Однако, какие бы слова субъекта и объекта я ни вводил, глагол, который он предсказывает, всегда "имел". Это данные обучающей выборки и прогнозные данные.

Интересно, что бы мне настроить сеть?

Это сеть, которую я использую (num_layers = 10, rnn_size = 50, learning_rate = 0.001, batch_size= 128):