Spark Streaming - Продолжительность работы против отправленного

Я пытаюсь оптимизировать приложение Spark Streaming, которое собирает данные из кластера Kafka, обрабатывает их и сохраняет результаты в различных таблицах базы данных. На вкладке "Задания" в пользовательском интерфейсе Spark отображается продолжительность каждого задания, а также время его отправки.

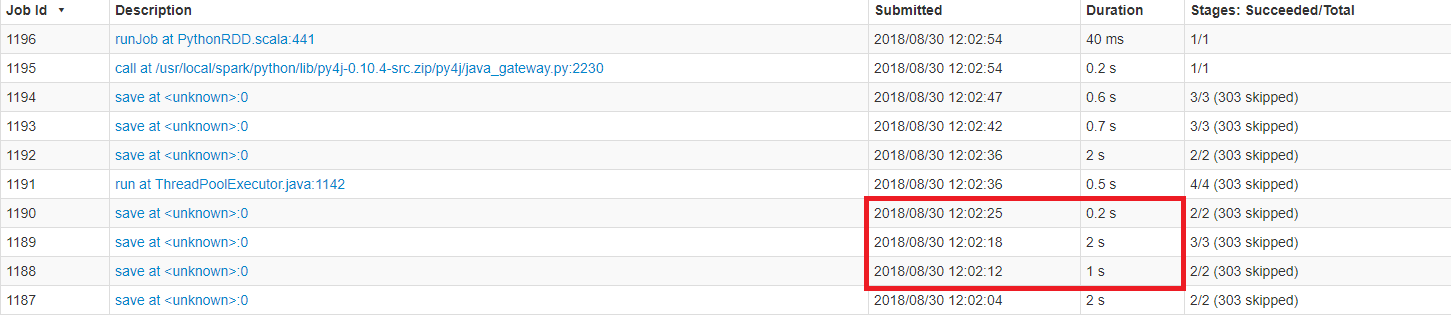

Я ожидаю, что для конкретной партии задание начинает обрабатываться после выполнения предыдущего задания. Однако на прикрепленном снимке экрана "Отправленное" время работы не сразу после завершения предыдущего. Например, задание 1188 имеет длительность 1 секунда и было отправлено в 12:02:12. Я ожидаю, что следующая работа будет представлена через секунду или, по крайней мере, близко к ней, но вместо этого она была отправлена через шесть секунд.

Любые идеи о том, как эту задержку можно объяснить? Эти задания принадлежат одной и той же партии и выполняются последовательно. Я знаю, что существует некоторая задержка планирования между заданиями и заданиями, но я не ожидаю, что она будет такой большой. Кроме того, временная шкала события этапа не показывает большой задержки планирования.

Я использую Pyspark в автономном режиме.