Является ли метод поиска по дереву Монте-Карло или итерация значения (или что-то еще)?

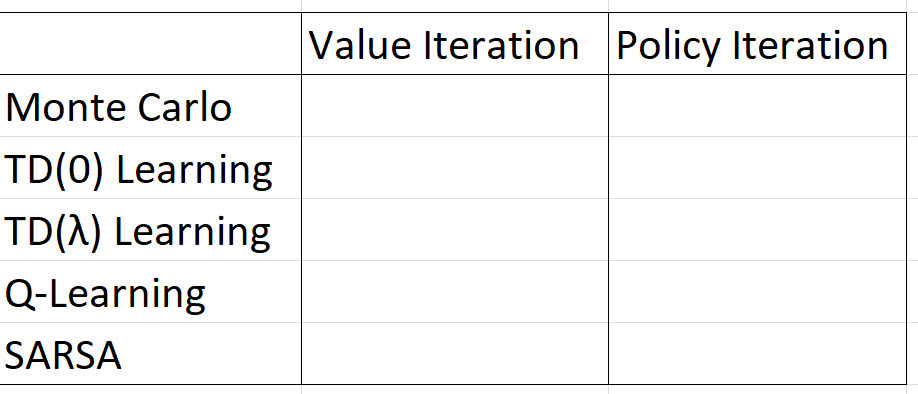

Я беру урок Reinforcement Learning, и я не понимал, как объединить концепции итерации / итерации политики с Монте-Карло (а также TD/SARSA/Q-learning). В таблице ниже, как можно заполнить пустые ячейки: Должен ли / может быть быть двоичным да / нет, какое-нибудь строковое описание или это более сложно?

1 ответ

Итерация значения и итерация политики - основанные на модели методы поиска оптимальной политики. Они пытаются построить марковский процесс принятия решений (MDP) из среды. Основная предпосылка обучения с подкреплением заключается в том, что вам не нужно MDP среды для поиска оптимальной политики, и традиционно итерация значения и итерация политики не считаются RL (хотя их понимание является ключом к концепциям RL). Итерация значений и итерация политики изучаются "косвенно", поскольку они образуют модель среды и могут затем извлечь оптимальную политику из этой модели.

"Прямые" методы обучения не пытаются построить модель среды. Они могут искать оптимальную политику в пространстве политик или использовать методы обучения, основанные на ценностных функциях (или "на основе ценностей"). Большинство подходов, о которых вы узнаете в эти дни, как правило, основаны на значениях функций.

Внутри методов, основанных на значениях функций, есть два основных типа методов обучения с подкреплением:

- Методы, основанные на итерациях политики

- Методы, основанные на итерациях значений

Ваша домашняя работа спрашивает вас, для каждого из этих методов RL, основаны ли они на итерации политики или итерации значения.

Подсказка: один из этих пяти методов RL не похож на другие.