Высокая дисперсия в тензорных потерях

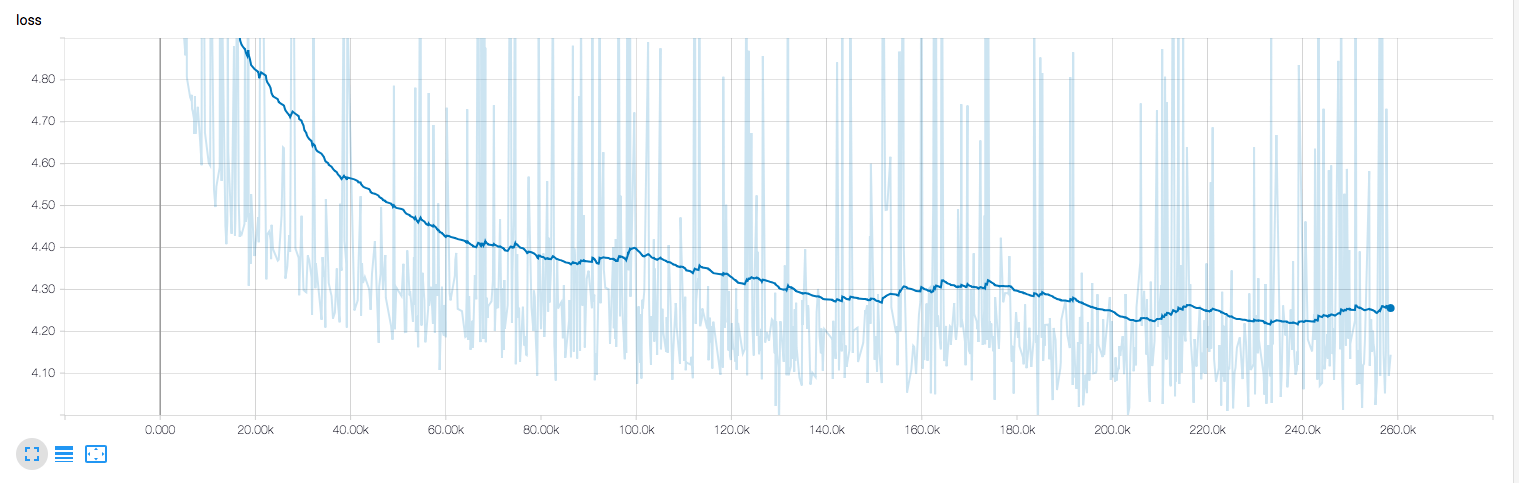

Я создаю языковую модель через Twitter с набором параметров transformer_big. Единственное изменение, которое я сделал, это max_length=64 (потому что твиты обычно короткие). Я использую 8 графических процессоров Tesla V100, и моя потеря выглядит так после сглаживания 0.99 на Tensor Board:

Из того, что я понимаю, эффективный размер партии составляет 4096*8, и потери, которые я вижу, усредняются по ~32К примерам. Из-за этого я думаю, что разница в потерях между двумя последующими партиями будет чрезвычайно мала, однако даже после более чем 250-килограммовых партий я часто вижу потери, столь же высокие, как я получил на шаге 10К.

Я пытался перетасовать данные вручную, увеличив размер пакета до 5 КБ и снизив скорость обучения до 0,01, но все это, похоже, не помогло. Есть ли у вас какие-либо идеи относительно того, что может вызвать это?