Как правильно читать декодированные образцы PCM на iOS с помощью AVAssetReader - в настоящее время некорректное декодирование

В настоящее время я работаю над приложением как часть моего бакалавра в области компьютерных наук. Приложение будет сопоставлять данные с аппаратного обеспечения iPhone (акселерометр, GPS) и музыку, которая воспроизводится.

Проект все еще находится в зачаточном состоянии, проработав над ним всего 2 месяца.

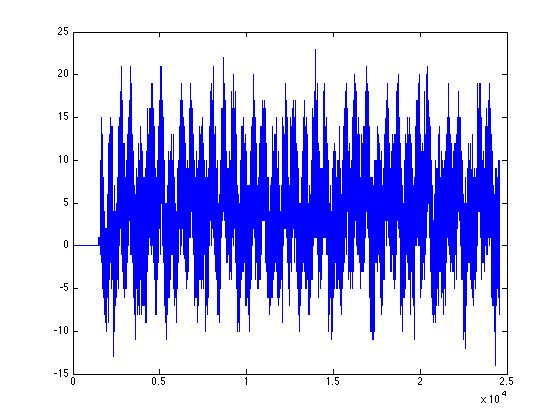

Момент, в котором я сейчас нахожусь и где мне нужна помощь, - это чтение сэмплов PCM из песен из библиотеки itunes и их воспроизведение с использованием аудиоустройства. В настоящее время реализация, над которой я бы хотел поработать, делает следующее: выбирает произвольную песню из iTunes, читает сэмплы из нее, когда это необходимо, и сохраняет ее в буфере, назовем ее sampleBuffer. Позже в потребительской модели аудиоустройство (которое имеет микшер и выход RemoteIO) имеет обратный вызов, где я просто копирую необходимое количество выборок из sampleBuffer в буфер, указанный в обратном вызове. То, что я потом слышу через динамики, - это не совсем то, что я ожидаю; Я могу распознать, что она играет песню, но кажется, что она неправильно декодирована и в ней много шума! Я приложил изображение, которое показывает первые ~ полсекунды (24576 сэмплов при 44,1 кГц), и это не похоже на нормальный вид вывода. Прежде чем попасть в список, я проверил, что файл не поврежден, аналогично я написал тестовые примеры для буфера (поэтому я знаю, что буфер не изменяет образцы), и хотя это может быть не лучшим способом сделать это (некоторые поспорили бы пойти по пути аудио-очереди), я хочу выполнить различные манипуляции с семплами, а также изменить песню до ее завершения, изменить порядок воспроизведения песни и т. д. Кроме того, возможно, в аудиосистеме есть некоторые неправильные настройки Однако, блок, который отображает сэмплы (которые показывают, что сэмплы неправильно декодируются) берется прямо из буфера, поэтому я только сейчас смотрю, чтобы решить, почему считывание с диска и декодирование не работают правильно. Прямо сейчас я просто хочу сыграть на работе. Не могу публиковать изображения, потому что новичок в stackru, поэтому вот ссылка на изображение:

Листинг:

Здесь я настраиваю audioReadSettigns, которые будут использоваться для AVAssetReaderAudioMixOutput

// Set the read settings

audioReadSettings = [[NSMutableDictionary alloc] init];

[audioReadSettings setValue:[NSNumber numberWithInt:kAudioFormatLinearPCM]

forKey:AVFormatIDKey];

[audioReadSettings setValue:[NSNumber numberWithInt:16] forKey:AVLinearPCMBitDepthKey];

[audioReadSettings setValue:[NSNumber numberWithBool:NO] forKey:AVLinearPCMIsBigEndianKey];

[audioReadSettings setValue:[NSNumber numberWithBool:NO] forKey:AVLinearPCMIsFloatKey];

[audioReadSettings setValue:[NSNumber numberWithBool:NO] forKey:AVLinearPCMIsNonInterleaved];

[audioReadSettings setValue:[NSNumber numberWithFloat:44100.0] forKey:AVSampleRateKey];

Теперь следующий листинг кода представляет собой метод, который получает строку NSString с persistant_id песни:

-(BOOL)setNextSongID:(NSString*)persistand_id {

assert(persistand_id != nil);

MPMediaItem *song = [self getMediaItemForPersistantID:persistand_id];

NSURL *assetUrl = [song valueForProperty:MPMediaItemPropertyAssetURL];

AVURLAsset *songAsset = [AVURLAsset URLAssetWithURL:assetUrl

options:[NSDictionary dictionaryWithObject:[NSNumber numberWithBool:YES]

forKey:AVURLAssetPreferPreciseDurationAndTimingKey]];

NSError *assetError = nil;

assetReader = [[AVAssetReader assetReaderWithAsset:songAsset error:&assetError] retain];

if (assetError) {

NSLog(@"error: %@", assetError);

return NO;

}

CMTimeRange timeRange = CMTimeRangeMake(kCMTimeZero, songAsset.duration);

[assetReader setTimeRange:timeRange];

track = [[songAsset tracksWithMediaType:AVMediaTypeAudio] objectAtIndex:0];

assetReaderOutput = [AVAssetReaderAudioMixOutput assetReaderAudioMixOutputWithAudioTracks:[NSArray arrayWithObject:track]

audioSettings:audioReadSettings];

if (![assetReader canAddOutput:assetReaderOutput]) {

NSLog(@"cant add reader output... die!");

return NO;

}

[assetReader addOutput:assetReaderOutput];

[assetReader startReading];

// just getting some basic information about the track to print

NSArray *formatDesc = ((AVAssetTrack*)[[assetReaderOutput audioTracks] objectAtIndex:0]).formatDescriptions;

for (unsigned int i = 0; i < [formatDesc count]; ++i) {

CMAudioFormatDescriptionRef item = (CMAudioFormatDescriptionRef)[formatDesc objectAtIndex:i];

const CAStreamBasicDescription *asDesc = (CAStreamBasicDescription*)CMAudioFormatDescriptionGetStreamBasicDescription(item);

if (asDesc) {

// get data

numChannels = asDesc->mChannelsPerFrame;

sampleRate = asDesc->mSampleRate;

asDesc->Print();

}

}

[self copyEnoughSamplesToBufferForLength:24000];

return YES;

}

Ниже представлена функция -(void)copyEnoughSamplesToBufferForLength:

-(void)copyEnoughSamplesToBufferForLength:(UInt32)samples_count {

[w_lock lock];

int stillToCopy = 0;

if (sampleBuffer->numSamples() < samples_count) {

stillToCopy = samples_count;

}

NSAutoreleasePool *apool = [[NSAutoreleasePool alloc] init];

CMSampleBufferRef sampleBufferRef;

SInt16 *dataBuffer = (SInt16*)malloc(8192 * sizeof(SInt16));

int a = 0;

while (stillToCopy > 0) {

sampleBufferRef = [assetReaderOutput copyNextSampleBuffer];

if (!sampleBufferRef) {

// end of song or no more samples

return;

}

CMBlockBufferRef blockBuffer = CMSampleBufferGetDataBuffer(sampleBufferRef);

CMItemCount numSamplesInBuffer = CMSampleBufferGetNumSamples(sampleBufferRef);

AudioBufferList audioBufferList;

CMSampleBufferGetAudioBufferListWithRetainedBlockBuffer(sampleBufferRef,

NULL,

&audioBufferList,

sizeof(audioBufferList),

NULL,

NULL,

0,

&blockBuffer);

int data_length = floorf(numSamplesInBuffer * 1.0f);

int j = 0;

for (int bufferCount=0; bufferCount < audioBufferList.mNumberBuffers; bufferCount++) {

SInt16* samples = (SInt16 *)audioBufferList.mBuffers[bufferCount].mData;

for (int i=0; i < numSamplesInBuffer; i++) {

dataBuffer[j] = samples[i];

j++;

}

}

CFRelease(sampleBufferRef);

sampleBuffer->putSamples(dataBuffer, j);

stillToCopy = stillToCopy - data_length;

}

free(dataBuffer);

[w_lock unlock];

[apool release];

}

Теперь sampleBuffer будет иметь неправильно декодированные сэмплы. Кто-нибудь может мне помочь, почему это так? Это происходит для разных файлов в моей медиатеке iTunes (mp3, aac, wav и т. Д.). Любая помощь будет принята с благодарностью, более того, если вам понадобится какой-либо другой список моего кода или, возможно, как будет звучать вывод, я приложу его к каждому запросу. Я сидел на этом в течение прошлой недели, пытаясь отладить это и не нашел помощи онлайн - все, кажется, обдумывают это в моем пути, все же кажется, что только у меня есть эта проблема.

Спасибо за любую помощь на всех!

Питер

3 ответа

В настоящее время я также работаю над проектом, который предусматривает извлечение аудиосэмплов из библиотеки iTunes в AudioUnit.

Аудиосигнал рендеринга включен для вашей справки. Формат ввода установлен как SInt16StereoStreamFormat.

Я использовал реализацию кольцевого буфера Майкла Тайсона - TPCircularBuffer в качестве буферного хранилища. Очень прост в использовании и понимании!!! Спасибо, Майкл!

- (void) loadBuffer:(NSURL *)assetURL_

{

if (nil != self.iPodAssetReader) {

[iTunesOperationQueue cancelAllOperations];

[self cleanUpBuffer];

}

NSDictionary *outputSettings = [NSDictionary dictionaryWithObjectsAndKeys:

[NSNumber numberWithInt:kAudioFormatLinearPCM], AVFormatIDKey,

[NSNumber numberWithFloat:44100.0], AVSampleRateKey,

[NSNumber numberWithInt:16], AVLinearPCMBitDepthKey,

[NSNumber numberWithBool:NO], AVLinearPCMIsNonInterleaved,

[NSNumber numberWithBool:NO], AVLinearPCMIsFloatKey,

[NSNumber numberWithBool:NO], AVLinearPCMIsBigEndianKey,

nil];

AVURLAsset *asset = [AVURLAsset URLAssetWithURL:assetURL_ options:nil];

if (asset == nil) {

NSLog(@"asset is not defined!");

return;

}

NSLog(@"Total Asset Duration: %f", CMTimeGetSeconds(asset.duration));

NSError *assetError = nil;

self.iPodAssetReader = [AVAssetReader assetReaderWithAsset:asset error:&assetError];

if (assetError) {

NSLog (@"error: %@", assetError);

return;

}

AVAssetReaderOutput *readerOutput = [AVAssetReaderAudioMixOutput assetReaderAudioMixOutputWithAudioTracks:asset.tracks audioSettings:outputSettings];

if (! [iPodAssetReader canAddOutput: readerOutput]) {

NSLog (@"can't add reader output... die!");

return;

}

// add output reader to reader

[iPodAssetReader addOutput: readerOutput];

if (! [iPodAssetReader startReading]) {

NSLog(@"Unable to start reading!");

return;

}

// Init circular buffer

TPCircularBufferInit(&playbackState.circularBuffer, kTotalBufferSize);

__block NSBlockOperation * feediPodBufferOperation = [NSBlockOperation blockOperationWithBlock:^{

while (![feediPodBufferOperation isCancelled] && iPodAssetReader.status != AVAssetReaderStatusCompleted) {

if (iPodAssetReader.status == AVAssetReaderStatusReading) {

// Check if the available buffer space is enough to hold at least one cycle of the sample data

if (kTotalBufferSize - playbackState.circularBuffer.fillCount >= 32768) {

CMSampleBufferRef nextBuffer = [readerOutput copyNextSampleBuffer];

if (nextBuffer) {

AudioBufferList abl;

CMBlockBufferRef blockBuffer;

CMSampleBufferGetAudioBufferListWithRetainedBlockBuffer(nextBuffer, NULL, &abl, sizeof(abl), NULL, NULL, kCMSampleBufferFlag_AudioBufferList_Assure16ByteAlignment, &blockBuffer);

UInt64 size = CMSampleBufferGetTotalSampleSize(nextBuffer);

int bytesCopied = TPCircularBufferProduceBytes(&playbackState.circularBuffer, abl.mBuffers[0].mData, size);

if (!playbackState.bufferIsReady && bytesCopied > 0) {

playbackState.bufferIsReady = YES;

}

CFRelease(nextBuffer);

CFRelease(blockBuffer);

}

else {

break;

}

}

}

}

NSLog(@"iPod Buffer Reading Finished");

}];

[iTunesOperationQueue addOperation:feediPodBufferOperation];

}

static OSStatus ipodRenderCallback (

void *inRefCon, // A pointer to a struct containing the complete audio data

// to play, as well as state information such as the

// first sample to play on this invocation of the callback.

AudioUnitRenderActionFlags *ioActionFlags, // Unused here. When generating audio, use ioActionFlags to indicate silence

// between sounds; for silence, also memset the ioData buffers to 0.

const AudioTimeStamp *inTimeStamp, // Unused here.

UInt32 inBusNumber, // The mixer unit input bus that is requesting some new

// frames of audio data to play.

UInt32 inNumberFrames, // The number of frames of audio to provide to the buffer(s)

// pointed to by the ioData parameter.

AudioBufferList *ioData // On output, the audio data to play. The callback's primary

// responsibility is to fill the buffer(s) in the

// AudioBufferList.

)

{

Audio* audioObject = (Audio*)inRefCon;

AudioSampleType *outSample = (AudioSampleType *)ioData->mBuffers[0].mData;

// Zero-out all the output samples first

memset(outSample, 0, inNumberFrames * kUnitSize * 2);

if ( audioObject.playingiPod && audioObject.bufferIsReady) {

// Pull audio from circular buffer

int32_t availableBytes;

AudioSampleType *bufferTail = TPCircularBufferTail(&audioObject.circularBuffer, &availableBytes);

memcpy(outSample, bufferTail, MIN(availableBytes, inNumberFrames * kUnitSize * 2) );

TPCircularBufferConsume(&audioObject.circularBuffer, MIN(availableBytes, inNumberFrames * kUnitSize * 2) );

audioObject.currentSampleNum += MIN(availableBytes / (kUnitSize * 2), inNumberFrames);

if (availableBytes <= inNumberFrames * kUnitSize * 2) {

// Buffer is running out or playback is finished

audioObject.bufferIsReady = NO;

audioObject.playingiPod = NO;

audioObject.currentSampleNum = 0;

if ([[audioObject delegate] respondsToSelector:@selector(playbackDidFinish)]) {

[[audioObject delegate] performSelector:@selector(playbackDidFinish)];

}

}

}

return noErr;

}

- (void) setupSInt16StereoStreamFormat {

// The AudioUnitSampleType data type is the recommended type for sample data in audio

// units. This obtains the byte size of the type for use in filling in the ASBD.

size_t bytesPerSample = sizeof (AudioSampleType);

// Fill the application audio format struct's fields to define a linear PCM,

// stereo, noninterleaved stream at the hardware sample rate.

SInt16StereoStreamFormat.mFormatID = kAudioFormatLinearPCM;

SInt16StereoStreamFormat.mFormatFlags = kAudioFormatFlagsCanonical;

SInt16StereoStreamFormat.mBytesPerPacket = 2 * bytesPerSample; // *** kAudioFormatFlagsCanonical <- implicit interleaved data => (left sample + right sample) per Packet

SInt16StereoStreamFormat.mFramesPerPacket = 1;

SInt16StereoStreamFormat.mBytesPerFrame = SInt16StereoStreamFormat.mBytesPerPacket * SInt16StereoStreamFormat.mFramesPerPacket;

SInt16StereoStreamFormat.mChannelsPerFrame = 2; // 2 indicates stereo

SInt16StereoStreamFormat.mBitsPerChannel = 8 * bytesPerSample;

SInt16StereoStreamFormat.mSampleRate = graphSampleRate;

NSLog (@"The stereo stream format for the \"iPod\" mixer input bus:");

[self printASBD: SInt16StereoStreamFormat];

}

Я полагаю, что уже поздно, но вы можете попробовать эту библиотеку:

https://bitbucket.org/artgillespie/tslibraryimport

После использования этого для сохранения аудио в файл вы можете обрабатывать данные с помощью обратных вызовов рендеринга из MixerHost.

На вашем месте я бы использовал kAudioUnitSubType_AudioFilePlayer, чтобы воспроизвести файл и получить доступ к его образцам с помощью обратного вызова модулей.

Или же

Используйте ExtAudioFileRef, чтобы извлечь образцы прямо в буфер.