Как выбрать действие в TD(0) обучения

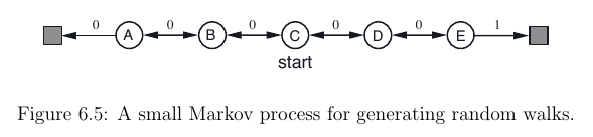

Я сейчас читаю Саттона Reinforcement Learning: An introduction книга. После прочтения главы 6.1 я хотел реализовать TD(0) Алгоритм RL для этой настройки:

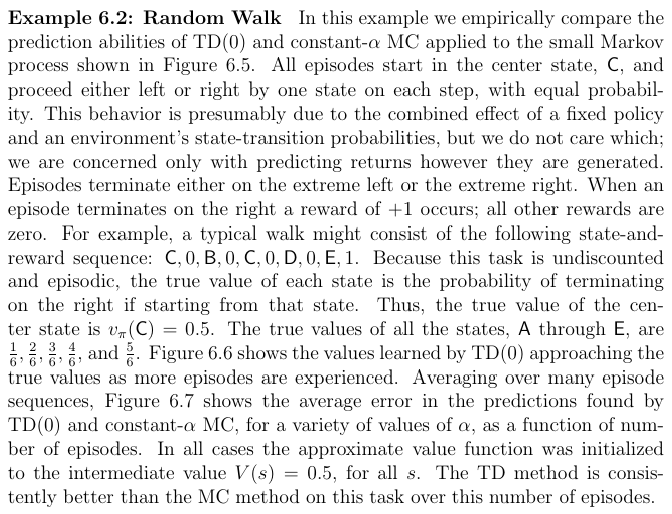

Для этого я попытался реализовать представленный здесь псевдокод:

Делая это, я задавался вопросом, как сделать этот шаг A <- action given by π for S: Могу ли я выбрать оптимальное действие A для моего текущего состояния S? В качестве значения функции V(S) Я просто не знаю, как это можно сделать, зависит только от состояния, а не от действия.

Я нашел этот вопрос (откуда я взял изображения), который касается того же упражнения, но здесь действие выбирается случайным образом, а не выбирается политикой действия. π,

Изменить: Или это псевдокод не завершен, так что я должен приблизить action-value function Q(s, a) по-другому тоже?

1 ответ

Вы правы, вы не можете выбрать действие (ни вывести политику π) только из функции значения V(s) потому что, как вы заметили, это зависит только от государства s,

Ключевая концепция, которую вы, вероятно, здесь упускаете, состоит в том, что обучение TD(0) является алгоритмом для вычисления функции значения данной политики. Таким образом, вы предполагаете, что ваш агент придерживается известной политики. В случае проблемы Случайного блуждания политика состоит в выборе действий случайным образом.

Если вы хотите научиться политике, вам нужно оценить функцию action-value Q(s,a), Существует несколько методов обучения Q(s,a) основанный на разнице во времени, такой как, например, SARSA и Q-learning.

В книге Р.Л. Саттона авторы различают два вида проблем: проблемы прогнозирования и проблемы управления. Первый относится к процессу оценки функции стоимости данной политики, а второй - к оценке политики (часто с помощью функций действия-значения). Вы можете найти ссылку на эти понятия в начальной части главы 6:

Как обычно, мы начнем с того, что сосредоточимся на оценке или прогнозировании политики, а именно на оценке функции стоимости для данной политики. Для задачи управления (поиск оптимальной политики) методы DP, TD и Monte Carlo используют некоторые варианты обобщенной итерации политики (GPI). Различия в методах - это, прежде всего, различия в подходах к проблеме прогнозирования.