Форматы временных меток и часовые пояса в Spark (scala API)

******* ОБНОВИТЬ ********

Как предложено в комментариях, я исключил не относящуюся к делу часть кода:

Мои требования:

- Унифицировать количество миллисекунд до 3

- Преобразовать строку в метку времени и сохранить значение в UTC

Создать фрейм данных:

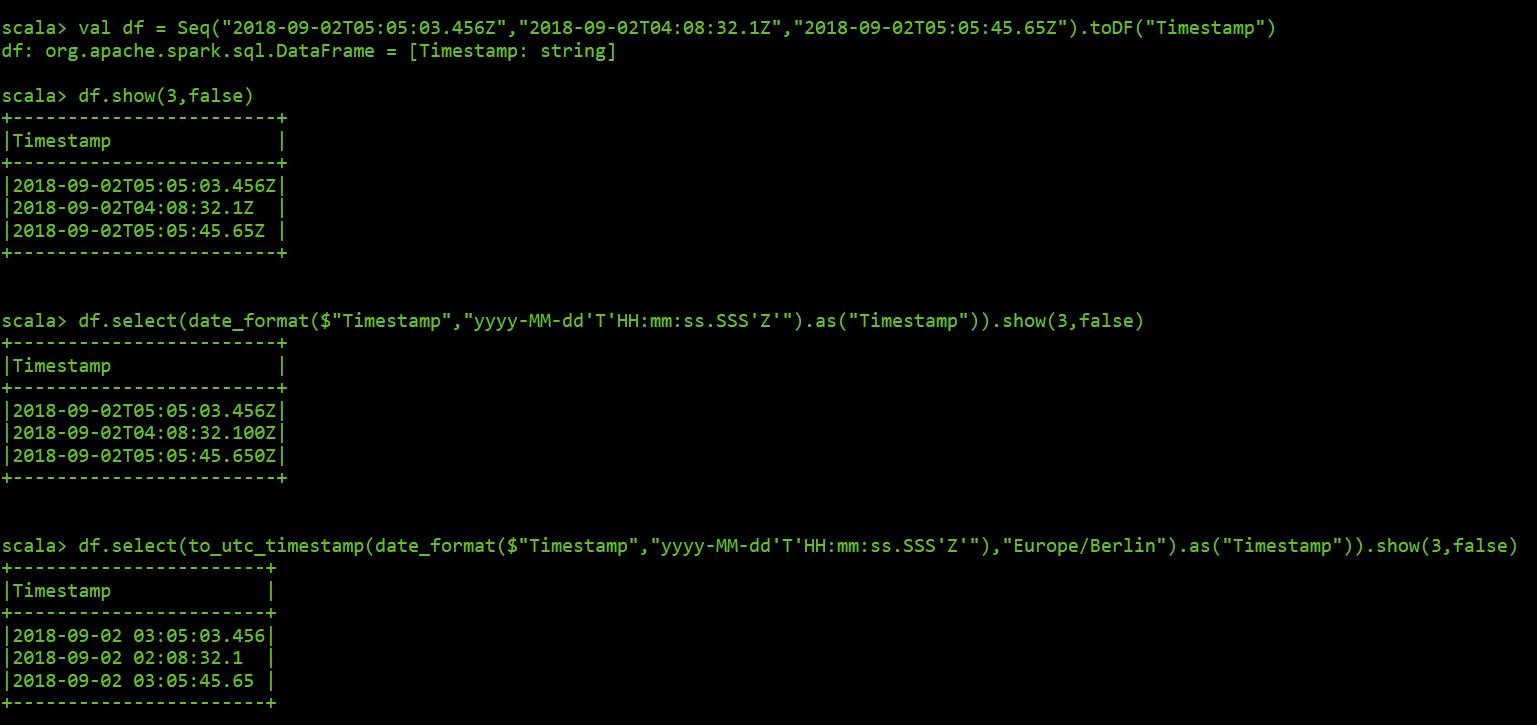

val df = Seq("2018-09-02T05:05:03.456Z","2018-09-02T04:08:32.1Z","2018-09-02T05:05:45.65Z").toDF("Timestamp")

Вот результаты с использованием искровой оболочки:

************ END UPDATE *********************************

У меня хорошая головная боль, когда я пытаюсь разобраться с часовыми поясами и форматами отметок времени в Spark, используя scala.

Это упрощение моего сценария, чтобы объяснить мою проблему:

import org.apache.spark.sql.functions._

val jsonRDD = sc.wholeTextFiles("file:///data/home2/phernandez/vpp/Test_Message.json")

val jsonDF = spark.read.json(jsonRDD.map(f => f._2))

Это результирующая схема:

root

|-- MeasuredValues: array (nullable = true)

| |-- element: struct (containsNull = true)

| | |-- MeasuredValue: double (nullable = true)

| | |-- Status: long (nullable = true)

| | |-- Timestamp: string (nullable = true)

Затем я просто выбираю поле Timestamp следующим образом

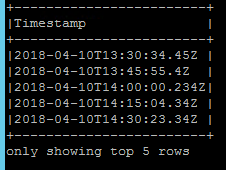

jsonDF.select(explode($"MeasuredValues").as("Values")).select($"Values.Timestamp").show(5,false)

Первое, что я хочу исправить, - это количество миллисекунд каждой метки времени и унифицировать его до трех.

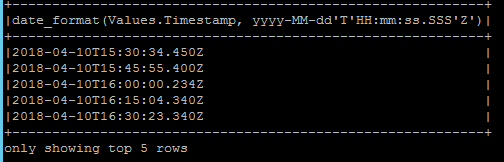

Я применил date_format следующим образом

jsonDF.select(explode($"MeasuredValues").as("Values")).select(date_format($"Values.Timestamp","yyyy-MM-dd'T'HH:mm:ss.SSS'Z'")).show(5,false)

Формат в миллисекундах был исправлен, но метка времени конвертируется из UTC в местное время.

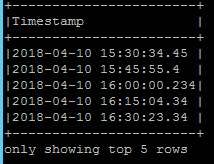

Чтобы решить эту проблему, я применил to_utc_timestamp вместе с моим местным часовым поясом.

jsonDF.select(explode($"MeasuredValues").as("Values")).select(to_utc_timestamp(date_format($"Values.Timestamp","yyyy-MM-dd'T'HH:mm:ss.SSS'Z'"),"Europe/Berlin").as("Timestamp")).show(5,false)

Хуже того, значение UTC не возвращается, а формат в миллисекундах теряется.

Есть идеи как с этим бороться? Я буду признателен за это

BR. Павел

1 ответ

Причиной проблемы является строка формата времени, используемая для преобразования:

yyyy-MM-dd'T'HH:mm:ss.SSS'Z'

Как вы можете видеть, Z находится внутри одинарных кавычек, что означает, что он не интерпретируется как маркер смещения зоны, а только как символ T в середине.

Таким образом, строка формата должна быть изменена на

yyyy-MM-dd'T'HH:mm:ss.SSSX

где X шаблон стандартного форматирования даты и времени Java (Z быть значением смещения для 0).

Теперь исходные данные можно преобразовать в метки времени UTC:

val srcDF = Seq(

("2018-04-10T13:30:34.45Z"),

("2018-04-10T13:45:55.4Z"),

("2018-04-10T14:00:00.234Z"),

("2018-04-10T14:15:04.34Z"),

("2018-04-10T14:30:23.45Z")

).toDF("Timestamp")

val convertedDF = srcDF.select(to_utc_timestamp(date_format($"Timestamp", "yyyy-MM-dd'T'HH:mm:ss.SSSX"), "Europe/Berlin").as("converted"))

convertedDF.printSchema()

convertedDF.show(false)

/**

root

|-- converted: timestamp (nullable = true)

+-----------------------+

|converted |

+-----------------------+

|2018-04-10 13:30:34.45 |

|2018-04-10 13:45:55.4 |

|2018-04-10 14:00:00.234|

|2018-04-10 14:15:04.34 |

|2018-04-10 14:30:23.45 |

+-----------------------+

*/

Если вам нужно преобразовать временные метки обратно в строки и нормализовать значения, чтобы иметь 3 конечных нуля, должен быть другой date_format звоните, похоже на то, что вы уже применили в вопросе.