Как использовать Privoxy и Tor для проекта Scrapy

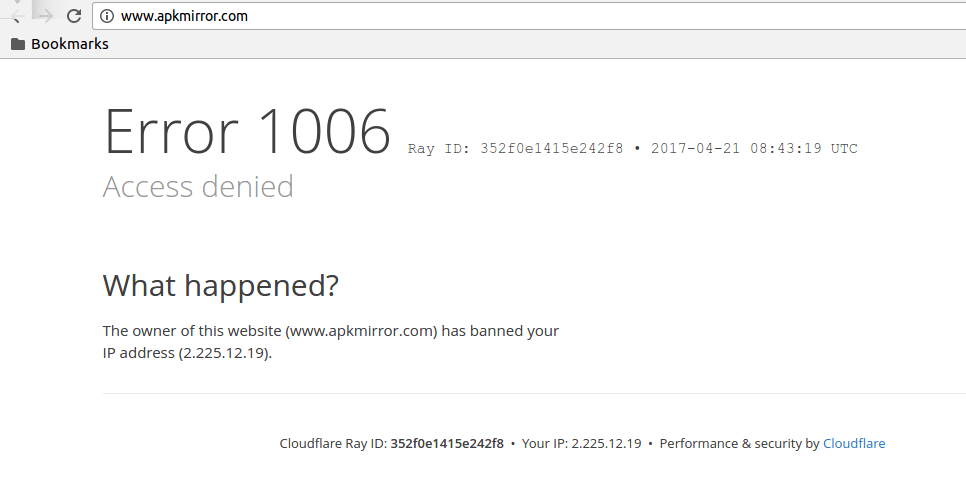

Я пытаюсь почистить http://www.apkmirror.com/, но в настоящее время я не могу получить доступ к сайту в моем браузере, потому что он говорит, что владелец заблокировал мой IP-адрес (см. Ниже).

Я пытаюсь обойти это, используя Privoxy и Tor, подобно тому, что описано в http://blog.michaelyin.info/2014/02/19/scrapy-socket-proxy/.

Во-первых, я установил запущенный Privoxy, который по умолчанию прослушивает порт 8118. Я добавил следующую строку в /etc/privoxy/config:

forward-socks5 / 127.0.0.1:9050 .

У меня также работает Tor, который прослушивает порт 9050, как проверено с помощью

kurt@kurt-ThinkPad:~$ netstat -tulnp | grep 9050

(Not all processes could be identified, non-owned process info

will not be shown, you would have to be root to see it all.)

tcp 0 0 127.0.0.1:9050 0.0.0.0:* LISTEN -

Насколько я могу сказать, используя wget, это работает. Например, если я wget apkmirror.com с помощью прокси я получаю ответ:

kurt@kurt-ThinkPad:~$ wget www.apkmirror.com -e use_proxy=yes -e http_proxy=127.0.0.1:8118

--2017-04-24 11:02:32-- http://www.apkmirror.com/

Connecting to 127.0.0.1:8118... connected.

Proxy request sent, awaiting response... 200 OK

Length: 185097 (181K) [text/html]

Saving to: ‘index.html.2’

index.html.2 100%[===================>] 180,76K --.-KB/s in 0,004s

2017-04-24 11:02:44 (42,7 MB/s) - ‘index.html.2’ saved [185097/185097]

тогда как без прокси я получаю ERROR 403: Forbidden:

kurt@kurt-ThinkPad:~$ wget www.apkmirror.com

--2017-04-24 11:01:24-- http://www.apkmirror.com/

Resolving www.apkmirror.com (www.apkmirror.com)... 104.19.134.58, 104.19.136.58, 104.19.133.58, ...

Connecting to www.apkmirror.com (www.apkmirror.com)|104.19.134.58|:80... connected.

HTTP request sent, awaiting response... 403 Forbidden

2017-04-24 11:01:24 ERROR 403: Forbidden.

Теперь для кода Python. Я написал следующий (упрощенный) паук:

import scrapy

DEBUG = True

class TorSpider(scrapy.spiders.SitemapSpider):

name = "tor-spider"

sitemap_urls = ['https://www.apkmirror.com/sitemap_index.xml']

sitemap_rules = [(r'.*-android-apk-download/$', 'parse')]

if DEBUG:

custom_settings = {'CLOSESPIDER_PAGECOUNT': 20}

def parse(self, response):

item = {'url': response.url}

yield item

Я также добавил следующие строки в settings.py:

import os

os.environ['http_proxy'] = "http://localhost:8118"

DOWNLOADER_MIDDLEWARES = {

'scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware': 1,

}

из того, что я понимаю из https://doc.scrapy.org/en/latest/topics/downloader-middleware.html, если я установлю http_proxy переменная окружения HttpProxyMiddleware должно сработать. Тем не менее, если я пытаюсь очистить с помощью команды

scrapy crawl tor-spider -o test.json

Я получаю следующий ответ:

2017-04-24 10:59:17 [scrapy.utils.log] INFO: Scrapy 1.3.3 started (bot: proxy_spider)

2017-04-24 10:59:17 [scrapy.utils.log] INFO: Overridden settings: {'NEWSPIDER_MODULE': 'proxy_spider.spiders', 'FEED_URI': 'test.json', 'SPIDER_MODULES': ['proxy_spider.spiders'], 'BOT_NAME': 'proxy_spider', 'ROBOTSTXT_OBEY': True, 'FEED_FORMAT': 'json'}

2017-04-24 10:59:18 [scrapy.middleware] INFO: Enabled extensions:

['scrapy.extensions.closespider.CloseSpider',

'scrapy.extensions.feedexport.FeedExporter',

'scrapy.extensions.logstats.LogStats',

'scrapy.extensions.telnet.TelnetConsole',

'scrapy.extensions.corestats.CoreStats']

2017-04-24 10:59:18 [scrapy.middleware] INFO: Enabled downloader middlewares:

['scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware',

'scrapy.downloadermiddlewares.robotstxt.RobotsTxtMiddleware',

'scrapy.downloadermiddlewares.httpauth.HttpAuthMiddleware',

'scrapy.downloadermiddlewares.downloadtimeout.DownloadTimeoutMiddleware',

'scrapy.downloadermiddlewares.defaultheaders.DefaultHeadersMiddleware',

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware',

'scrapy.downloadermiddlewares.retry.RetryMiddleware',

'scrapy.downloadermiddlewares.redirect.MetaRefreshMiddleware',

'scrapy.downloadermiddlewares.httpcompression.HttpCompressionMiddleware',

'scrapy.downloadermiddlewares.redirect.RedirectMiddleware',

'scrapy.downloadermiddlewares.cookies.CookiesMiddleware',

'scrapy.downloadermiddlewares.stats.DownloaderStats']

2017-04-24 10:59:18 [scrapy.middleware] INFO: Enabled spider middlewares:

['scrapy.spidermiddlewares.httperror.HttpErrorMiddleware',

'scrapy.spidermiddlewares.offsite.OffsiteMiddleware',

'scrapy.spidermiddlewares.referer.RefererMiddleware',

'scrapy.spidermiddlewares.urllength.UrlLengthMiddleware',

'scrapy.spidermiddlewares.depth.DepthMiddleware']

2017-04-24 10:59:18 [scrapy.middleware] INFO: Enabled item pipelines:

[]

2017-04-24 10:59:18 [scrapy.core.engine] INFO: Spider opened

2017-04-24 10:59:18 [scrapy.extensions.logstats] INFO: Crawled 0 pages (at 0 pages/min), scraped 0 items (at 0 items/min)

2017-04-24 10:59:18 [scrapy.extensions.telnet] DEBUG: Telnet console listening on 127.0.0.1:6024

2017-04-24 10:59:18 [scrapy.core.engine] DEBUG: Crawled (403) <GET https://www.apkmirror.com/robots.txt> (referer: None)

2017-04-24 10:59:18 [scrapy.core.engine] DEBUG: Crawled (403) <GET https://www.apkmirror.com/sitemap_index.xml> (referer: None)

2017-04-24 10:59:18 [scrapy.spidermiddlewares.httperror] INFO: Ignoring response <403 https://www.apkmirror.com/sitemap_index.xml>: HTTP status code is not handled or not allowed

2017-04-24 10:59:18 [scrapy.core.engine] INFO: Closing spider (finished)

2017-04-24 10:59:18 [scrapy.statscollectors] INFO: Dumping Scrapy stats:

{'downloader/request_bytes': 519,

'downloader/request_count': 2,

'downloader/request_method_count/GET': 2,

'downloader/response_bytes': 3110,

'downloader/response_count': 2,

'downloader/response_status_count/403': 2,

'finish_reason': 'finished',

'finish_time': datetime.datetime(2017, 4, 24, 8, 59, 18, 927878),

'log_count/DEBUG': 3,

'log_count/INFO': 8,

'response_received_count': 2,

'scheduler/dequeued': 1,

'scheduler/dequeued/memory': 1,

'scheduler/enqueued': 1,

'scheduler/enqueued/memory': 1,

'start_time': datetime.datetime(2017, 4, 24, 8, 59, 18, 489419)}

2017-04-24 10:59:18 [scrapy.core.engine] INFO: Spider closed (finished)

Короче, я все еще получаю 403 ошибка со скребком, несмотря на попытку анонимной очистки с помощью Privoxy/Tor. Я делаю что-то неправильно?

1 ответ

akpmirror использует cloudflare для защиты себя (в том числе) от соскабливания и ботов.

Скорее всего, у них есть стандартный пользовательский агент Scrapy в черном списке. Поэтому в дополнение к использованию IP-адреса tor (который, кстати, также может быть легко помещен в черный список), вы также должны установить заголовок пользовательского агента, который выглядит как настоящий браузер:

в settings.py

USER_AGENT = "Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:53.0) Gecko/20100101 Firefox/53.0"

(см. https://doc.scrapy.org/en/latest/topics/settings.html для подробной информации)