Алгоритм трассировки, порядок обновления

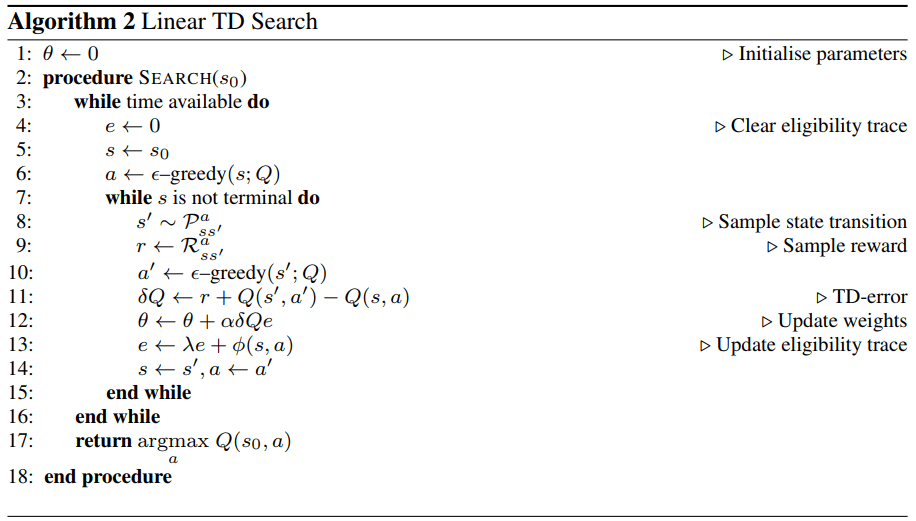

Я читаю Silver et al (2012) "Поиск различий во времени на компьютере" и пытаюсь понять порядок обновления для алгоритма трассировки приемлемости. В Алгоритме 1 и 2 статьи веса обновляются перед обновлением трассы приемлемости. Интересно, правильный ли этот порядок (строки 11 и 12 в алгоритме 1 и строки 12 и 13 алгоритма 2). Думая о крайнем случае с lambda=0параметр не обновляется исходной парой состояние-действие (поскольку e все еще 0). Поэтому я сомневаюсь, что порядок, возможно, должен быть противоположным.

Может кто-то прояснить суть?

Я нахожу этот документ очень поучительным для изучения области обучения подкреплению, поэтому хотел бы разобраться в этом документе подробно.

Если есть более подходящая платформа, чтобы задать этот вопрос, пожалуйста, дайте мне знать.

1 ответ

Мне кажется, ты прав, e должно быть обновлено до theta, Это также должно произойти в соответствии с математикой в газете. См., Например, уравнения (7) и (8), где e_t сначала вычисляется с использованием phi(s_t)и только тогда theta обновлено с помощью delta V_t (что будет delta Q в контрольном случае).

Обратите внимание, что вы написали о крайнем случае с lambda=0 не совсем правильно. Начальная пара состояние-действие все еще будет участвовать в обновлении (не в первой итерации, но они будут включены в e во время второй итерации). Тем не менее, это выглядит для меня как самая первая награда r никогда не будет использоваться в каких-либо обновлениях (потому что это появляется только в самой первой итерации, где e все еще 0). Поскольку эта статья о Go, я подозреваю, что это не будет иметь значения; если они не делают что-то необычное, они, вероятно, используют ненулевое вознаграждение только для состояния конечной игры.